Большие языковые модели (LLM): что это такое и как они устроены?

ChatGPT, Gemini, Claude, Copilot – все эти AI-инструменты работают на одной фундаментальной технологии: больших языковых моделях LLM. Они изменили представление о том, что искусственный интеллект способен понимать и создавать текст, код, изображения и даже рассуждения, близкие к человеческим.

Поэтому, далее, мы разберемся с ответами на вопросы: «LLM что это такое?», как устроены такие модели, почему именно они стали ядром современных AI-систем и в чем заключается их прорыв?

Что такое LLM и почему они стали прорывом в AI-разработке?

LLM (расшифровка Large Language Model LLM) это нейросеть, обученная на колоссальных массивах текстовых данных. Она анализирует контекст, строит связи между словами и предсказывает, какое слово или символ должно идти дальше.

Отвечая на вопрос, что такое LLM, простыми словами – это система, которая учится понимать язык так, как человек, но делает это статистически: она не «знает», а угадывает с высокой точностью.

Главный прорыв LLM – в универсальности. Если старые AI-модели решали узкие задачи (например, классифицировали отзывы или определяли объекты на фото), то LLM способны выполнять десятки сценариев без переподготовки: от написания кода и анализа данных – до ведения диалога и генерации изображений.

Эта технология лежит в основе ключевых продуктов:

- ChatGPT (OpenAI) – универсальный AI-ассистент, понимающий контекст и язык.

- Gemini (Google DeepMind) – объединяет текст, изображения и поиск в единую систему.

- Claude (Anthropic) – делает ставку на безопасность и точные рассуждения.

- GitHub Copilot (Microsoft) – применяет возможности LLM для помощи разработчикам в написании кода.

LLM стали базовой инфраструктурой новой эпохи искусственного интеллекта – универсальными мозгами, на которых строятся AI-продукты для бизнеса, науки и повседневной жизни.

Как устроены LLM модели?

Чтобы понять, как LLM модели создают осмысленный текст, нужно заглянуть внутрь их архитектуры. В их основе – модель трансформера (Transformer), представленная в 2017 году исследователями Google. Этот принцип позволил компьютеру не просто обрабатывать слова по очереди, а учитывать весь контекст предложения сразу.

Архитектура и принципы работы

В классической архитектуре нейросетей каждое слово обрабатывалось отдельно – это делало модель «слепой» к контексту.

Трансформер же работает иначе: он анализирует все предложение целиком, определяя, какие слова связаны между собой и как они влияют на смысл.

Этот механизм называется self-attention (самовнимание) – он позволяет модели понимать не просто слова, а их роль в контексте.

В LLM миллиарды таких «вниманий» и взаимосвязей. Чем больше параметров и данных – тем точнее модель улавливает смысл, стиль, тон и даже эмоции в тексте.

Что такое токены и параметры?

Текст для модели – это не слова, а токены – фрагменты текста, из которых она «собирает» смысл. Например, слово «программирование» может быть разбито на несколько токенов: «програм», «мир», «ование». Каждый токен – как кирпич в конструкции фразы.

Параметры – это внутренние настройки модели (веса нейронных связей), которые определяют, как модель реагирует на каждый токен. Так, один из параметров может описывать насколько сильно слово «не» должно менять смысл следующего слова. Например, в фразе «не плохой фильм» параметр, связанный с отрицанием, помогает модели понять, что это не то же самое, что «плохой фильм».

У GPT-4 их около 1,8 триллиона. Именно эти параметры формируют способность модели понимать контекст и предсказывать логичное продолжение текста.

Процесс генерации текста

Когда пользователь вводит запрос, LLM не ищет готовый ответ в базе. Она пошагово предсказывает следующее слово, опираясь на вероятность появления каждого токена в данном контексте.

Примерно так:

- Модель получает текст: «Большие языковые модели – это…».

- Она вычисляет вероятности для следующего токена – например, «системы», «нейросети» или «AI».

- Выбирает наиболее вероятный вариант и повторяет процесс, пока не сформирует полный ответ.

По сути, LLM не вспоминает, а прогнозирует, создавая текст в реальном времени, опираясь на закономерности, усвоенные при обучении.

Именно поэтому она может не просто цитировать источники, а генерировать новые формулировки, примеры и объяснения, которых нет в исходных данных.

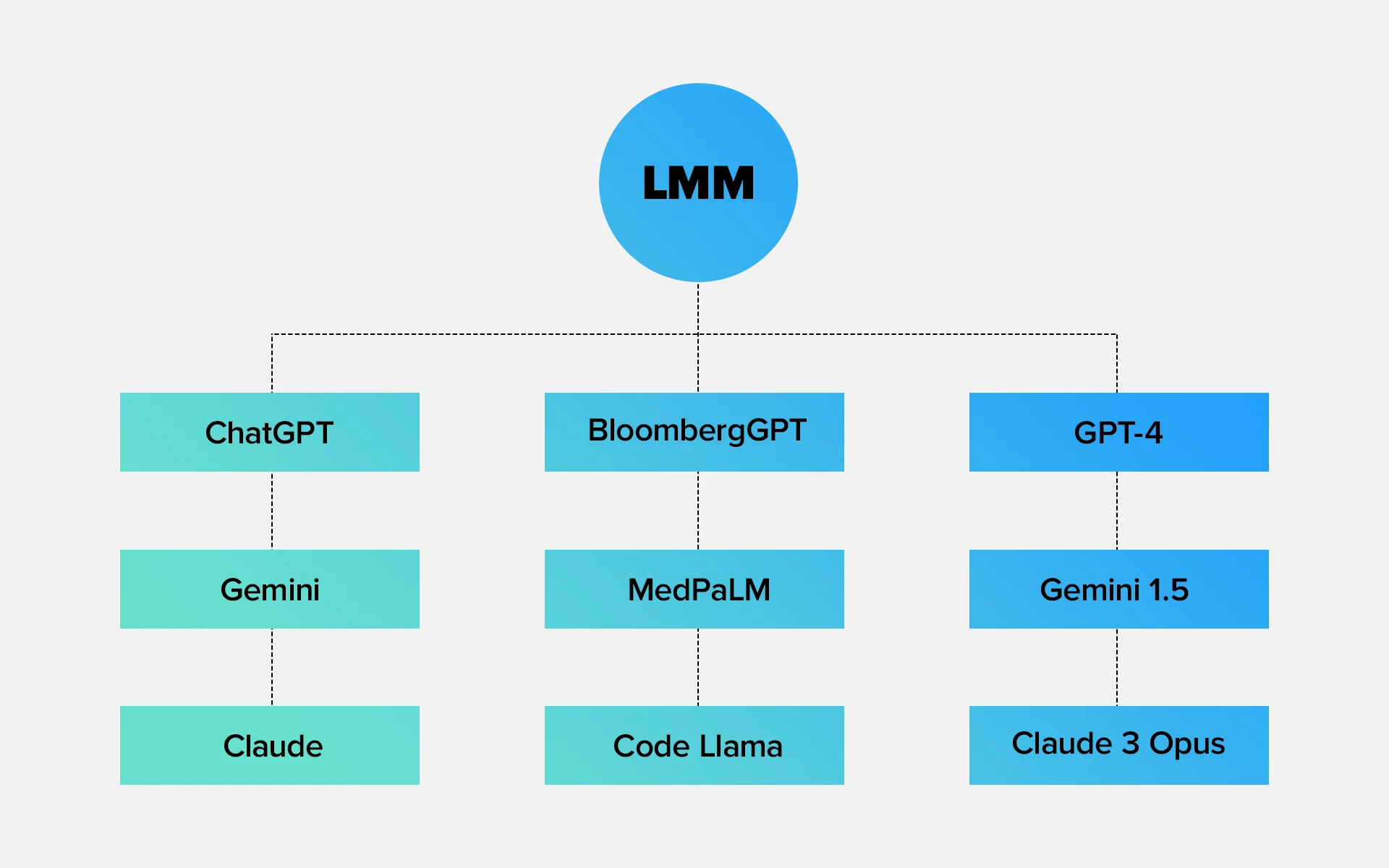

Какими бывают модели LLM?

Не все большие языковые модели одинаковы. Одни созданы быть универсальными и работать с любыми задачами, другие – решают конкретные профессиональные сценарии, а третьи – объединяют разные типы данных: текст, изображение, видео или звук. Разберем основные типы LLM и приведем реальные примеры.

Универсальные языковые модели (ChatGPT, Gemini, Claude)

Это «универсальные ассистенты», способные писать тексты, объяснять сложные темы, писать код и анализировать данные. Такие модели обучаются на широких корпусах текстов: книги, статьи, википедия, репозитории кода. Их задача – максимально точно понимать язык и уметь работать с любым контекстом.

- ChatGPT (OpenAI) – гибкий AI, ориентированный на универсальное общение, анализ и генерацию контента.

- Gemini (Google DeepMind) – совмещает знание поисковых данных и текстовые возможности, превращаясь в интеллектуальный поисково-аналитический инструмент.

- Claude (Anthropic) – делает упор на «мягкое мышление» и безопасность, выдает рассуждения, близкие по логике к человеческим.

Универсальные LLM – основа современных AI-продуктов: от чат-ботов и систем поддержки до корпоративных ассистентов и инструментов аналитики.

Узкоспециализированные LLM (BloombergGPT, MedPaLM, Code Llama)

Когда важна глубина в конкретной области, создают специализированные модели. Они обучаются не на всём интернете, а на профильных данных – финансовых документах, медицинских исследованиях, исходном коде и т.д.

- BloombergGPT – модель для финансового анализа и работы с рынками. Понимает отчеты, прогнозирует риски, анализирует новости.

- MedPaLM (Google Research) – обучена на медицинских публикациях и клинических данных, помогает врачам анализировать симптомы и рекомендации.

- Code Llama (Meta) – версия LLaMA, адаптированная для написания и объяснения кода, аналог GitHub Copilot, но open-source.

Такие модели не универсальны, зато точны в своей нише. Они снижают вероятность ошибок и ускоряют работу специалистов, особенно там, где цена неточности высока – в финансах, медицине и инженерии.

Мультимодальные модели (GPT-4, Gemini 1.5, Claude 3 Opus)

Мультимодальные LLM – следующий шаг развития. Они понимают не только текст, но и изображения, видео, таблицы, голосовые данные. Это делает взаимодействие с AI ближе к человеческому: можно показать, а не только описать.

- GPT-4 – умеет анализировать изображения, понимать диаграммы, интерпретировать фото и код.

- Gemini 1.5 – соединяет текст, визуальный ввод и поисковую аналитику Google.

- Claude 3 Opus – понимает сложные документы с графиками, таблицами и может объяснять визуальные данные словами.

Мультимодальные LLM открывают путь к интеграции AI в дизайн, медиа, науку, образование – везде, где важно связывать разные типы информации.

Как обучаются и где применяются LLM?

Чтобы модель начала понимать язык и выдавать логичные ответы, она проходит два ключевых этапа обучения: предобучение и дообучение (fine-tuning).

Эти фазы формируют «базовое понимание мира» и позволяют адаптировать AI под конкретные задачи.

Этапы предобучения и дообучения

Предобучение (pre-training). На этом этапе модель читает миллиарды текстов: книги, сайты, статьи, исходный код. Цель – научиться предсказывать следующее слово в любой последовательности.

После предобучения модель уже умеет говорить, но делает это обобщённо, без четкой цели.

Дообучение (fine-tuning). Здесь модель «доводят» под конкретную задачу. Например:

- ChatGPT обучают на диалогах, чтобы он вёл осмысленный разговор;

- MedPaLM – на медицинских данных, чтобы корректно интерпретировать диагнозы;

- Copilot – на репозиториях кода, чтобы помогать разработчикам писать программы.

Часто используют дополнительную технику – RLHF (Reinforcement Learning from Human Feedback), где человек оценивает ответы модели и помогает ей «понять», какие формулировки считаются качественными.

Основные направления применения больших языковых моделей

LLM уже стали стандартом для множества сфер. Вот ключевые направления, где они приносят реальную пользу:

- Клиентская поддержка: автоматизация ответов, чат-боты, обработка обращений.

- Разработка ПО: генерация кода, автодополнение, ревью, документация.

- Контент и маркетинг: написание текстов, заголовков, SEO-оптимизация.

- Аналитика и исследования: поиск закономерностей, обобщение данных, прогнозирование.

- Образование: объяснение тем, подготовка учебных материалов, адаптация под уровень ученика.

- Медицина и наука: поиск закономерностей в исследованиях, помощь врачам, анализ публикаций.

LLM Large Language Models это уже не лабораторная технология, а универсальный слой интеллекта. Для компаний это уже не вопрос «нужен ли нам AI», а вопрос скорости внедрения. На уровне практики это превращается в конкретные AI решения: чат-боты на базе LLM, ассистенты для сотрудников, умные поисковые системы по внутренним данным.

Какие большие языковые модели сейчас самые популярные?

На рынке AI уже сформировался свой «олимп» – несколько моделей, которые задают стандарт качества и возможностей для всей индустрии. Они отличаются философией, архитектурой и направлением развития, но все опираются на одну идею – сделать взаимодействие человека и машины естественным.

GPT-4 (OpenAI)

Одна из самых известных и технологичных LLM в мире. Лежит в основе ChatGPT и используется в продуктах Microsoft – Copilot, Bing Chat, Office 365.

Главные особенности:

- поддержка мультимодальности – работает не только с текстом, но и с изображениями;

- высокая точность при генерации кода и аналитике;

- умение рассуждать и объяснять свои ответы.

GPT-4 обучена на триллионах токенов и миллионах диалогов, что делает ее универсальным инструментом для бизнеса, образования, аналитики и программирования.

Claude 3 (Anthropic)

Создана компанией Anthropic, основанной бывшими инженерами OpenAI. Философия Claude – этичный и безопасный AI, минимизирующий ошибки и манипуляции. Отличительные черты:

- «человечный» стиль общения – модель рассуждает, уточняет и аргументирует;

- акцент на точности, особенно в длинных контекстах (до сотен тысяч токенов);

- подходит для аналитических задач, написания документации и поддержки клиентов.

Claude 3 стал выбором многих компаний, где приоритет – осознанные ответы и конфиденциальность данных.

Gemini 1.5 (Google DeepMind)

Флагманская модель Google, пришедшая на смену Bard. Gemini 1.5 – мультимодальный AI, объединяющий работу с текстом, видео, изображениями и поисковыми данными. Особенности:

- умеет читать PDF, анализировать диаграммы и видеокадры;

- использует поисковые алгоритмы Google для актуальных ответов;

- оптимизирован под задачи исследовательского и корпоративного анализа.

Gemini – пример того, как Google соединяет свой поисковый интеллект и нейронные модели в единую экосистему. На практике это особенно заметно в том, как Google меняет выдачу и добавляет поверх классического поиска (AI поиск в Google), где LLM сразу формируют развернутые ответы и обзоры.

Mistral и Mixtral (Mistral AI)

Легкие open-source модели для локального запуска, популярны среди разработчиков.

Французский стартап Mistral AI стал сенсацией open-source-сообщества. Их модели Mistral 7B и Mixtral 8×7B показывают отличные результаты при малом размере. Ключевые плюсы:

- полностью открытый код и возможность локального запуска;

- лёгкие и быстрые в сравнении с коммерческими LLM;

- Mixtral использует архитектуру Mixture-of-Experts (MoE), которая включает нужные подмодели только при необходимости – это экономит ресурсы без потери качества.

Mistral сегодня – выбор разработчиков, стартапов и компаний, которым важна автономность и контроль над данными.

LLaMA 3 (Meta AI)

Третье поколение открытой модели от Meta AI. LLaMA 3 сочетает производительность уровня GPT-4 с возможностью адаптации под частные проекты. Особенности:

- open-source-лицензия, подходящая для коммерческого использования;

- отличная интеграция с Python, PyTorch и облачными платформами;

- хорошо масштабируется и обучается под конкретные сценарии: чат-боты, внутренние ассистенты, анализ документов.

LLaMA 3 активно используется в корпоративных решениях, где важен контроль, кастомизация и безопасность данных.

В чем недостатки Large Language Models?

Несмотря на впечатляющие возможности, LLM нельзя считать идеальными.

Они уже меняют то, как люди создают контент, пишут код и ищут информацию, – но их ограничения напрямую влияют на качество и безопасность использования. Основные недостатки:

- Галлюцинации (hallucinations). Модель может уверенно выдавать неверные факты. LLM не «знает» истину, а предсказывает слова по вероятности. Если данных не хватает, она дополняет пробелы домыслами. Пример: модель может «придумать» источник, цитату или ссылку, которой не существует.

- Зависимость от обучающих данных. Все, чему модель учится, – отражение данных, на которых она была обучена. Если в этих данных есть ошибки, предвзятость или устаревшая информация – они перейдут в ответы.

- Высокая стоимость обучения и обслуживания. Обучение LLM требует сотен GPU и терабайт памяти. Даже использование больших моделей обходится дорого. Поэтому не все компании могут позволить себе собственные модели – чаще используют готовые API.

- Ограниченная «понимаемость». Модель не осознаёт смысл, не имеет намерений и не способна на самокоррекцию без вмешательства человека. Она не анализирует истину – лишь воспроизводит вероятное.

- Риски конфиденциальности. При использовании облачных моделей есть риск утечки данных – особенно если пользователь передает личную или корпоративную информацию. Именно поэтому все чаще появляются локальные open-source модели (Mistral, LLaMA), позволяющие контролировать данные внутри компании.

Большие языковые модели – это мощный инструмент, но не универсальное решение. Они способны анализировать тексты, писать код, объяснять сложные темы и даже вести диалог на уровне эксперта. Однако важно помнить: LLM не мыслят, а моделируют мышление.

Там, где человек опирается на смысл, они полагаются на статистику. Там, где мы ищем истину, они вычисляют вероятность.

Чем LLM отличаются от других AI-систем?

Чтобы понять роль больших языковых моделей, важно сравнить их с другими типами искусственного интеллекта. Классические AI-системы решали конкретные задачи: классифицировать, распознавать, предсказывать. LLM – пошли дальше: они понимают и генерируют смысл, а не просто обрабатывают данные.

Критерий | Классические AI((Logistic Regression, Random Forest, SVM) | LLM (Large Language Models) GPT-4, Claude 3, Gemini |

Тип задач | Узкие, заранее определенные | Универсальные, многофункциональные |

Данные | Структурированные (таблицы, метки) | Неструктурированные тексты, код, изображения |

Принцип работы | Алгоритм + правила | Статистическое предсказание токенов |

Контекст | Понимает ограниченно | Анализирует длинный контекст, связи, тон |

Обучение | Под задачу | Масштабное предобучение + дообучение |

Гибкость | Низкая | Очень высокая, один инструмент – много задач |

Генерация контента | Нет | Да: текст, код, описания, анализ |

Ошибки | Формальные | Галлюцинации, домыслы |

Применение | Классификация, распознавание | Диалог, код, аналитика, поиск, мультимодальность |

В итоге большие языковые модели не заменяют классический AI, а поднимают его на новый уровень. Таблица выше хорошо показывает разницу: если традиционные системы решали одну узкую задачу, то LLM становятся универсальным интерфейсом к данным, знаниям и бизнес-процессам.