Великі мовні моделі (LLM): що це таке і як вони влаштовані?

ChatGPT, Gemini, Claude, Copilot – всі ці AI-інструменти працюють на одній фундаментальній технології: великих мовних моделях LLM. Вони змінили уявлення про те, що штучний інтелект здатний розуміти та створювати текст, код, зображення і навіть міркування, близькі до людських.

Тому, далі, ми розберемося з відповідями на питання: «LLM це?», як влаштовані такі моделі, чому саме вони стали ядром сучасних AI-систем і в чому полягає їхній прорив?

Що таке LLM і чому вони стали проривом у AI-розробці?

LLM (розшифровка Large Language Model LLM) – це нейромережа (велика мовна модель), навчена на колосальних масивах текстових даних. Вона аналізує контекст, будує зв'язки між словами та передбачає, яке слово або символ має йти далі.

Відповідаючи на питання, що таке LLM, простими словами – це система, яка вчиться розуміти мову так, як людина, але робить це статистично: вона не «знає», а вгадує з високою точністю.

Головний прорив LLM – в універсальності. Якщо старі AI-моделі вирішували вузькі завдання (наприклад, класифікували відгуки або визначали об'єкти на фото), то LLM здатні виконувати десятки сценаріїв без перепідготовки: від написання коду й аналізу даних – до ведення діалогу та генерації зображень.

Ця технологія лежить в основі ключових продуктів:

- ChatGPT (OpenAI) – універсальний AI-асистент, що розуміє контекст і мову.

- Gemini (Google DeepMind) – об'єднує текст, зображення та пошук в єдину систему.

- Claude (Anthropic) – робить ставку на безпеку і точні міркування.

- GitHub Copilot (Microsoft) – застосовує можливості LLM для допомоги розробникам у написанні коду.

LLM стали базовою інфраструктурою нової епохи штучного інтелекту – універсальними мозками, на яких будуються AI-продукти для бізнесу, науки та повсякденного життя.

Як влаштовані LLM моделі?

Щоб зрозуміти, як моделі LLM створюють осмислений текст, потрібно зазирнути всередину їхньої архітектури. В їхній основі – модель трансформера (Transformer), представлена у 2017 році дослідниками Google. Цей принцип дозволив комп'ютеру не просто обробляти слова по черзі, а враховувати весь контекст речення одразу.

Архітектура та принципи роботи

У класичній архітектурі нейромереж кожне слово оброблялося окремо – це робило модель «сліпою» до контексту.

Трансформер же працює інакше: він аналізує все речення цілком, визначаючи, які слова пов'язані між собою і як вони впливають на сенс.

Цей механізм називається self-attention (самоувага) – він дозволяє моделі розуміти не просто слова, а їхню роль у контексті.

В LLM мільярди таких «уваг» і взаємозв'язків. Чим більше параметрів і даних – тим точніше модель вловлює сенс, стиль, тон і навіть емоції в тексті.

Що таке токени та параметри?

Текст для моделі – це не слова, а токени – фрагменти тексту, з яких вона «збирає» сенс. Наприклад, слово «програмування» може бути розбите на кілька токенів: «програму», «вання». Кожен токен – як цеглина в конструкції фрази.

Параметри – це внутрішні налаштування моделі (ваги нейронних зв'язків), які визначають, як модель реагує на кожен токен. Наприклад, у фразі «не поганий фільм» параметр, пов'язаний із запереченням, допомагає моделі зрозуміти, що це не те саме, що «поганий фільм».

У GPT-4 їх близько 1,8 трильйона. Саме ці параметри формують здатність моделі розуміти контекст і передбачати логічне продовження тексту.

Процес генерації тексту

Коли користувач вводить запит, LLM не шукає готову відповідь у базі. Вона покроково передбачає наступне слово, спираючись на ймовірність появи кожного токена в даному контексті.

Приблизно так:

- Модель отримує текст: «Мовні моделі штучного інтелекту – це…».

- Вона обчислює ймовірності для наступного токена – наприклад, «системи», «нейромережі» або «AI».

- Обирає найбільш ймовірний варіант і повторює процес, доки не сформує повну відповідь.

По суті, LLM не згадує, а прогнозує, створюючи текст у реальному часі, спираючись на закономірності, засвоєні під час навчання.

Саме тому вона може не просто цитувати джерела, а генерувати нові формулювання, приклади та пояснення, яких немає у вихідних даних.

Якими бувають моделі LLM?

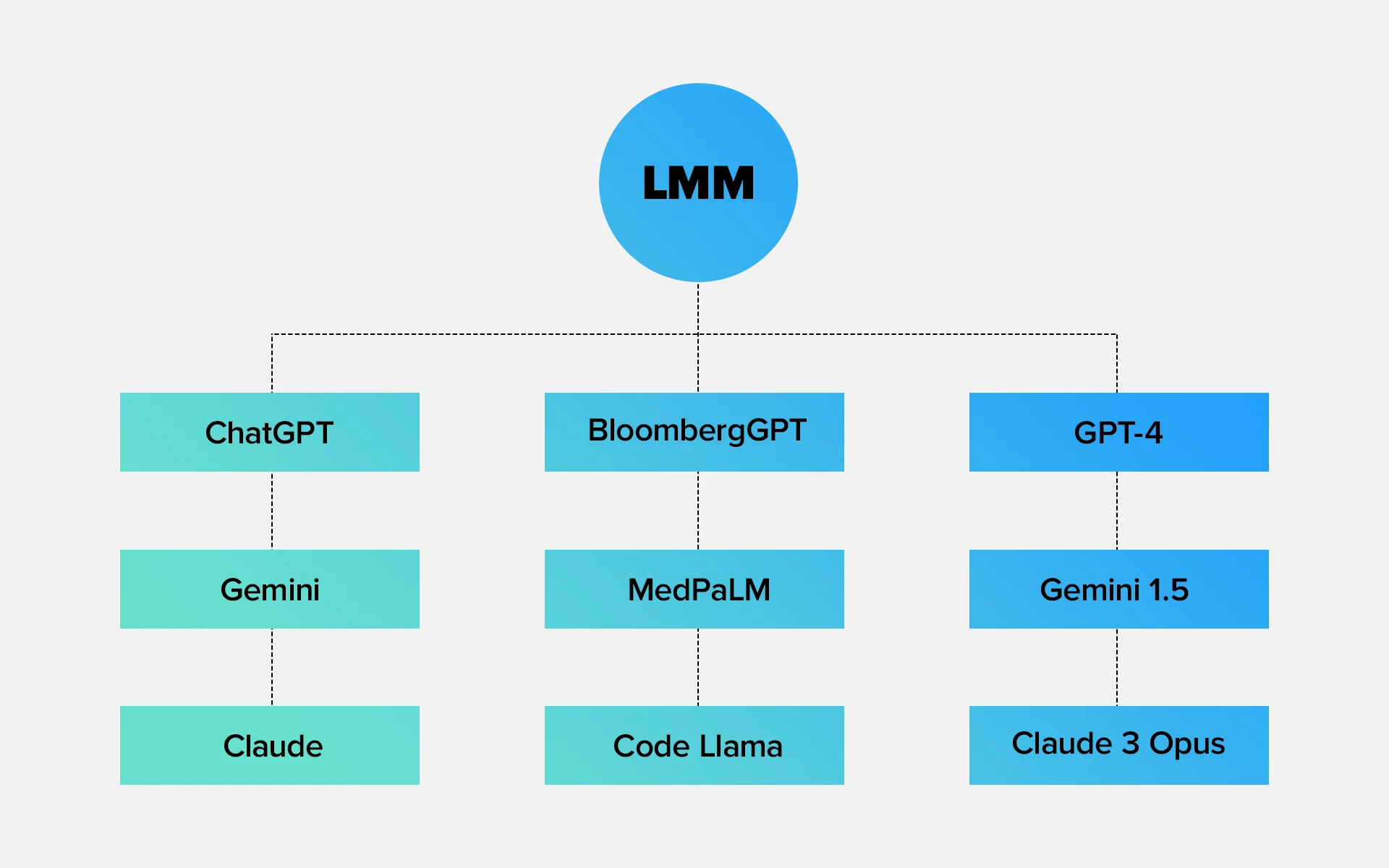

Не всі великі мовні моделі однакові. Одні створені бути універсальними і працювати з будь-якими завданнями, інші – вирішують конкретні професійні сценарії, а треті – об'єднують різні типи даних: текст, зображення, відео або звук. Розберемо основні типи LLM і наведемо реальні приклади.

Універсальні мовні моделі (ChatGPT, Gemini, Claude)

Це «універсальні асистенти», здатні писати тексти, пояснювати складні теми, писати код та аналізувати дані. Такі моделі навчаються на широких корпусах текстів: книги, статті, вікіпедія, репозиторії коду. Їхнє завдання – максимально точно розуміти мову та вміти працювати з будь-яким контекстом.

- ChatGPT (OpenAI) – гнучкий AI, орієнтований на універсальне спілкування, аналіз і генерацію контенту.

- Gemini (Google DeepMind) – поєднує знання пошукових даних та текстові можливості, перетворюючись на інтелектуальний пошуково-аналітичний інструмент.

- Claude (Anthropic) – робить акцент на «м'якому мисленні» та безпеці, видає міркування, близькі за логікою до людських.

Універсальні LLM – основа сучасних AI-продуктів: від чат-ботів і систем підтримки до корпоративних асистентів та інструментів аналітики.

Вузькоспеціалізовані LLM (BloombergGPT, MedPaLM, Code Llama)

Коли важлива глибина в конкретній області, створюють спеціалізовані моделі. Вони навчаються не на всьому інтернеті, а на профільних даних – фінансових документах, медичних дослідженнях, вихідному коді тощо.

- BloombergGPT – модель для фінансового аналізу та роботи з ринками. Розуміє звіти, прогнозує ризики, аналізує новини.

- MedPaLM (Google Research) – навчена на медичних публікаціях і клінічних даних, допомагає лікарям аналізувати симптоми та рекомендації.

- Code Llama (Meta) – версія LLaMA, адаптована для написання та пояснення коду, аналог GitHub Copilot, але open-source.

Такі моделі не універсальні, зате точні у своїй ніші. Вони знижують ймовірність помилок і прискорюють роботу фахівців, особливо там, де ціна неточності висока – у фінансах, медицині та інженерії.

Мультимодальні моделі (GPT-4, Gemini 1.5, Claude 3 Opus)

Мультимодальні LLM – наступний крок розвитку. Вони розуміють не лише текст, а й зображення, відео, таблиці, голосові дані. Це робить взаємодію з AI ближчою до людської: можна показати, а не лише описати.

- GPT-4 – вміє аналізувати зображення, розуміти діаграми, інтерпретувати фото та код.

- Gemini 1.5 – поєднує текст, візуальне введення та пошукову аналітику Google.

- Claude 3 Opus – розуміє складні документи з графіками, таблицями та може пояснювати візуальні дані словами.

Мультимодальні LLM відкривають шлях до інтеграції AI у дизайн, медіа, науку, освіту – скрізь, де важливо пов'язувати різні типи інформації.

Як навчаються і де застосовуються LLM?

Щоб модель почала розуміти мову та видавати логічні відповіді, вона проходить два ключові етапи навчання: попереднє навчання та донавчання (fine-tuning).

Ці фази формують «базове розуміння світу» і дозволяють адаптувати AI під конкретні завдання.

Етапи попереднього навчання та донавчання

Попереднє навчання (pre-training). На цьому етапі модель читає мільярди текстів: книги, сайти, статті, вихідний код. Мета – навчитися передбачати наступне слово в будь-якій послідовності. Після попереднього навчання модель вже вміє говорити, але робить це узагальнено, без чіткої мети.

Донавчання (fine-tuning). Тут модель «доводять» під конкретне завдання. Наприклад:

- ChatGPT навчають на діалогах, щоб він вів осмислену розмову;

- MedPaLM – на медичних даних, щоб коректно інтерпретувати діагнози;

- Copilot – на репозиторіях коду, щоб допомагати розробникам писати програми.

Часто використовують додаткову техніку – RLHF (Reinforcement Learning from Human Feedback), де людина оцінює відповіді моделі та допомагає їй «зрозуміти», які формулювання вважаються якісними.

Основні напрямки застосування великих мовних моделей

LLM вже стали стандартом для багатьох сфер. Ось ключові напрямки, де вони приносять реальну користь:

- Клієнтська підтримка: автоматизація відповідей, чат-боти, обробка звернень.

- Розробка ПЗ: генерація коду, автодоповнення, рев'ю, документація.

- Контент і маркетинг: написання текстів, заголовків, SEO-оптимізація.

- Аналітика та дослідження: пошук закономірностей, узагальнення даних, прогнозування.

- Освіта: пояснення тем, підготовка навчальних матеріалів, адаптація під рівень учня.

- Медицина і наука: пошук закономірностей у дослідженнях, допомога лікарям, аналіз публікацій.

LLM Large Language Models – це вже не лабораторна технологія, а універсальний шар інтелекту. Для компаній це вже не питання «чи потрібен нам AI», а питання швидкості впровадження. На рівні практики це перетворюється на конкретні AI рішення: чат-боти на базі LLM, асистенти для співробітників, розумні пошукові системи за внутрішніми даними.

Які великі мовні моделі зараз найпопулярніші?

На ринку AI вже сформувався свій «олімп» – кілька моделей, які задають стандарт якості та можливостей для всієї індустрії. Вони відрізняються філософією, архітектурою та напрямком розвитку, але всі спираються на одну ідею – зробити взаємодію людини та машини природною.

GPT-4 (OpenAI)

Одна з найвідоміших і технологічних LLM у світі. Лежить в основі ChatGPT і використовується в продуктах Microsoft. Головні особливості:

- підтримка мультимодальності – працює не лише з текстом, а й із зображеннями;

- висока точність при генерації коду та аналітиці;

- вміння міркувати та пояснювати свої відповіді.

GPT-4 навчена на трильйонах токенів і мільйонах діалогів.

Claude 3 (Anthropic)

Створена компанією Anthropic, заснованою колишніми інженерами OpenAI. Філософія Claude – етичний та безпечний AI, що мінімізує помилки та маніпуляції. Відмінні риси:

- «людяний» стиль спілкування – модель міркує, уточнює та аргументує;

- акцент на точності, особливо в довгих контекстах (до сотень тисяч токенів);

- підходить для аналітичних завдань, написання документації та підтримки клієнтів.

Claude 3 став вибором багатьох компаній, де пріоритет – усвідомлені відповіді та конфіденційність даних.

Gemini 1.5 (Google DeepMind)

Флагманська модель Google, що прийшла на зміну Bard. Gemini 1.5 – мультимодальний AI, що об'єднує роботу з текстом, відео, зображеннями та пошуковими даними.

Особливості:

- вміє читати PDF, аналізувати діаграми та відеокадри;

- використовує пошукові алгоритми Google для актуальних відповідей;

- оптимізований під завдання дослідницького та корпоративного аналізу.

Gemini – приклад того, як Google поєднує свій пошуковий інтелект і нейронні моделі в єдину екосистему. На практиці це особливо помітно в тому, як Google змінює видачу та додає поверх класичного пошуку (AI пошук у Google), де LLM одразу формують розгорнуті відповіді та огляди.

Mistral та Mixtral (Mistral AI)

Легкі open-source моделі для локального запуску, популярні серед розробників.

Французький стартап Mistral AI став сенсацією open-source-спільноти. Їхні моделі Mistral 7B та Mixtral 8×7B показують відмінні результати при малому розмірі. Ключові плюси:

- повністю відкритий код і можливість локального запуску;

- легкі та швидкі у порівнянні з комерційними LLM;

- Mixtral використовує архітектуру Mixture-of-Experts (MoE), яка включає потрібні підмоделі лише за необхідності – це економить ресурси без втрати якості.

Mistral сьогодні – вибір розробників, стартапів і компаній, яким важлива автономність і контроль над даними.

LLaMA 3 (Meta AI)

Третє покоління відкритої моделі від Meta AI. LLaMA 3 поєднує продуктивність рівня GPT-4 з можливістю адаптації під приватні проєкти.

Особливості:

- open-source-ліцензія, придатна для комерційного використання;

- відмінна інтеграція з Python, PyTorch та хмарними платформами;

- добре масштабується та навчається під конкретні сценарії: чат-боти, внутрішні асистенти, аналіз документів.

LLaMA 3 активно використовується в корпоративних рішеннях, де важливий контроль, кастомізація та безпека даних.

У чому недоліки Large Language Models?

Незважаючи на вражаючі можливості, LLM не можна вважати ідеальними.

Вони вже змінюють те, як люди створюють контент, пишуть код і шукають інформацію, – але їхні обмеження безпосередньо впливають на якість і безпеку використання. Основні недоліки:

- Галюцинації (hallucinations). Модель може впевнено видавати невірні факти. LLM не «знає» істину, а передбачає слова за ймовірністю. Якщо даних не вистачає, вона доповнює прогалини домислами. Приклад: модель може «придумати» джерело, цитату або посилання, якого не існує.

- Залежність від навчальних даних. Усе, чому модель навчається, – відображення даних, на яких вона була навчена. Якщо в цих даних є помилки, упередженість або застаріла інформація – вони перейдуть у відповіді.

- Висока вартість навчання та обслуговування. Навчання LLM вимагає сотень GPU та терабайт пам'яті. Навіть використання великих моделей обходиться дорого. Тому не всі компанії можуть дозволити собі власні моделі – частіше використовують готові API.

- Обмежена «зрозумілість». Модель не усвідомлює сенс, не має намірів і не здатна до самокорекції без втручання людини. Вона не аналізує істину – лише відтворює ймовірне.

- Ризики конфіденційності. При використанні хмарних моделей є ризик витоку даних – особливо якщо користувач передає особисту або корпоративну інформацію. Саме тому все частіше з'являються локальні open-source моделі (Mistral, LLaMA), що дозволяють контролювати дані всередині компанії.

Великі мовні моделі – це потужний інструмент, але не універсальне рішення. Вони здатні аналізувати тексти, писати код, пояснювати складні теми і навіть вести діалог на рівні експерта. Однак важливо пам'ятати: LLM не мислять, а моделюють мислення.

Там, де людина спирається на сенс, вони покладаються на статистику. Там, де ми шукаємо істину, вони обчислюють ймовірність.

Чим LLM відрізняються від інших AI-систем?

Щоб зрозуміти роль великих мовних моделей, важливо порівняти їх з іншими типами штучного інтелекту. Класичні AI-системи вирішували конкретні завдання: класифікувати, розпізнавати, передбачати. LLM – пішли далі: вони розуміють і генерують сенс, а не просто обробляють дані.

Критерій | Класичні AI (Logistic Regression, Random Forest, SVM) | LLM (Large Language Models) GPT-4, Claude 3, Gemini |

Тип задач | Вузькі, заздалегідь визначені | Універсальні, багатофункціональні |

Дані | Структуровані (таблиці, мітки) | Неструктуровані тексти, код, зображення |

Принцип роботи | Алгоритм + правила | Статистичне передбачення токенів |

Контекст | Розуміє обмежено | Аналізує довгий контекст, зв'язки, тон |

Навчання | Під задачу | Масштабне попереднє навчання + донавчання |

Гнучкість | Низька | Дуже висока, один інструмент – багато завдань |

Генерація контенту | Ні | Так: текст, код, описи, аналіз |

Помилки | Формальні | Галюцинації, домисли |

Застосування | Класифікація, розпізнавання | Діалог, код, аналітика, пошук, мультимодальність |

У підсумку, великі мовні моделі не замінюють класичний AI, а піднімають його на новий рівень. Таблиця вище добре показує різницю: якщо традиційні системи вирішували одне вузьке завдання, то LLM стають універсальним інтерфейсом до даних, знань і бізнес-процесів.