Screaming Frog SEO Spider: анализ результатов парсинга

Успешный аудит сайта — это фундамент оптимизации SEO. В этой статье разберем инструмент для проведения технического SEO-аудита сайта Screaming Frog. Рассмотрим возможности программы, которыми чаще всего пользуюсь при аудите сайта.

Начнем с загрузки программы.

Скачать Screaming Frog можно на официальном сайте www.screamingfrog.co.uk Программа бесплатная, но за полный функционал придется заплатить. Бесплатная версия включает скриминг 500 Urls и не поддерживает дополнительные расширения.

За годовую подписку на расширенную версию придется потратить около 6 тыс. грн. Если вы SEO-специалист, эта программа must-have на “Рабочем столе”, она существенно облегчит и ускорит сбор и анализ технических недочетов сайта.

Разбор функционала, которым чаще всего пользуюсь.

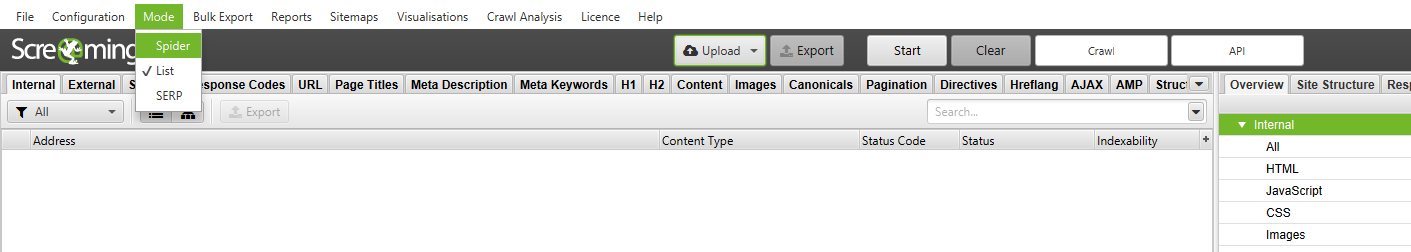

Скриминг фрог позволяет сканировать сайт несколькими способами:

- Spider:

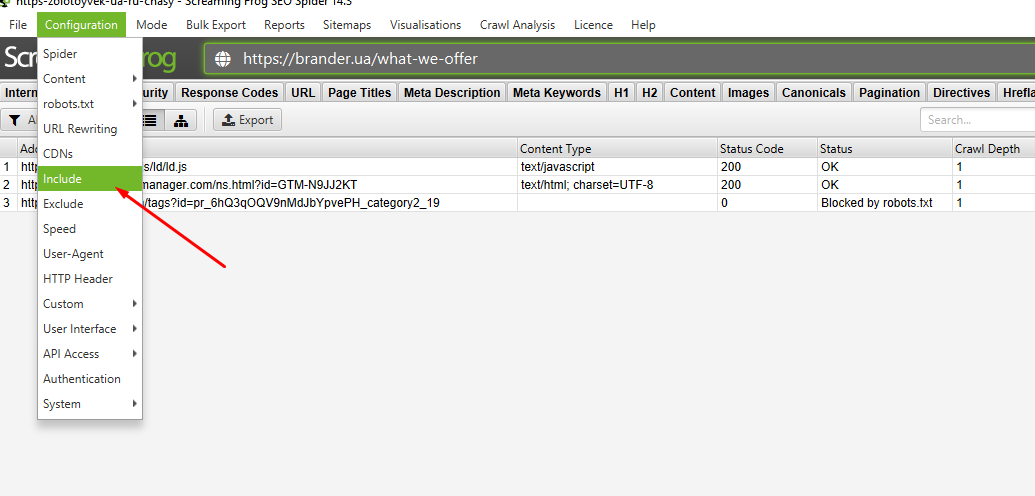

Сканирование всего сайта, программ ходит по всем URLs ресурса. Это дает полный анализ сайта и позволяет обнаружить все “битые” ссылки. У метода есть недостаток, который заключается в том, что если у сайта поврежденные JS-скрипты или проблемы с пагинацией, сканирование может уйти в бесконечный цикл. Что же делать? Выход есть, с помощью конфигурации Include или Extend можно обозначить парсингуемый раздел или исключить соответственно. Например:

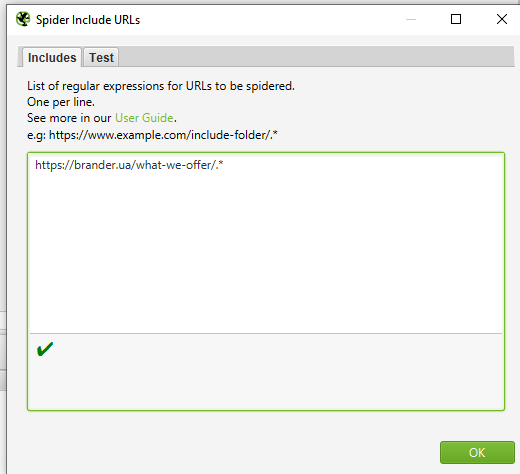

Есть задача спарсить раздел сайта brander.ua/what-we-offer. Для этого я добавляю правило в Configuration — Include.

Затем с помощью регулярного выражения (синтаксис указан в окне) ввожу нужный для сканирования раздел.

Старт и вуаля. Мы просканировали только отдельную категорию на сайте. Бывают ситуации, когда необходимые для сканирования страницы не лежат в какой-либо вложенности, а просканировать сайт полностью нет возможности по ряду причин (объем сайта, ломаный js и тд.). Тогда действуем от обратного. Можно внести в исключения Extend все категории, что существенно уменьшит количество урлов, и успешно спарсить остаток.

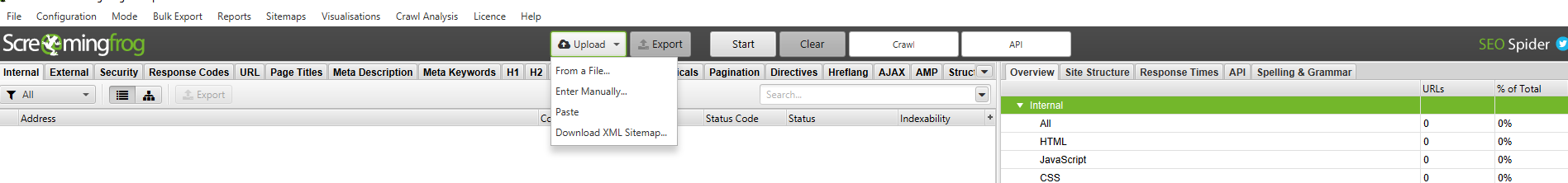

- List:

Сканирование сайта по списку URLs. Список необходимых для сканирования страниц вы можете вставить как файлом, так и мануально. У сканирования List также есть недостаток. Если есть список урлов, и хочешь спарсить только внешние ссылки, то в отчете лист сделать этого нельзя. Данный метод парсит только конкретные URL и не проходится по ним “пауком”.

Есть возможность просканировать SiteMap. Это позволяет находить ошибки на проиндексированных страницах.

- SERP:

Этот режим не сканирует сайт, а создан для работы с мета-текстами. Можно загрузить меты, редактировать и просматривать, как они отображаются в браузере.

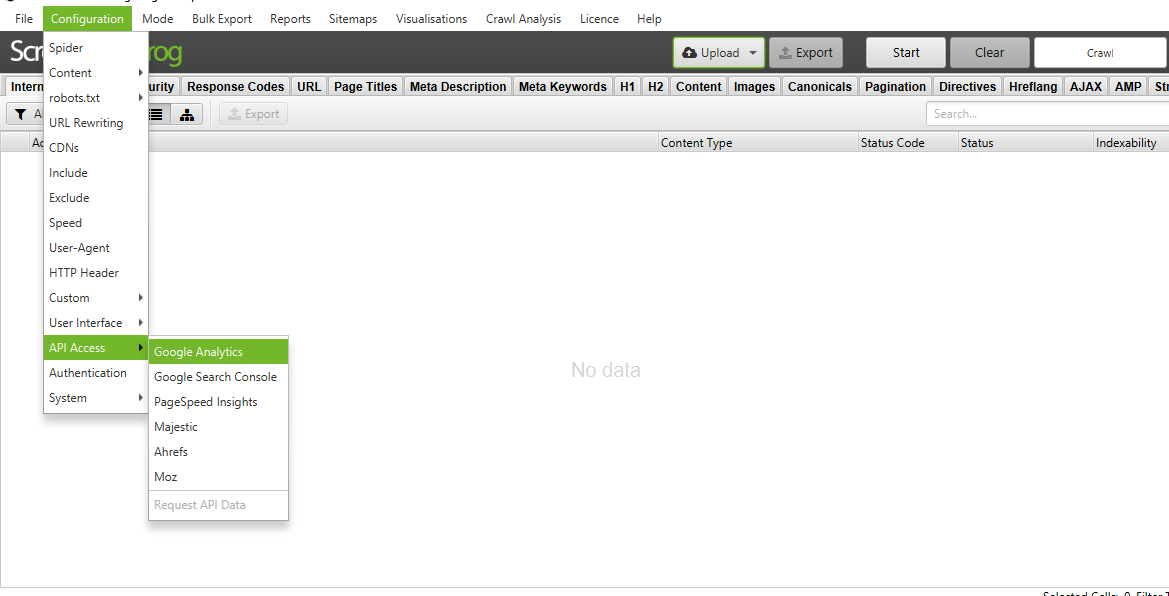

Перед началом сканирования сайта рекомендую подключить аналитику, что позволит не делать отдельных анализов по всем сервисам, а выгрузить все и сразу. Доступна аналитика по Google Analytics, Search Console, Moz, Pagespeed, Ahrefs, Majestiks. Это можно сделать с помощью вкладки Configuration — API Access.

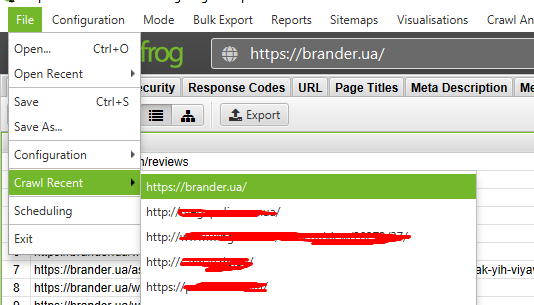

История парсинга находится во вкладке File — Craw Resent.

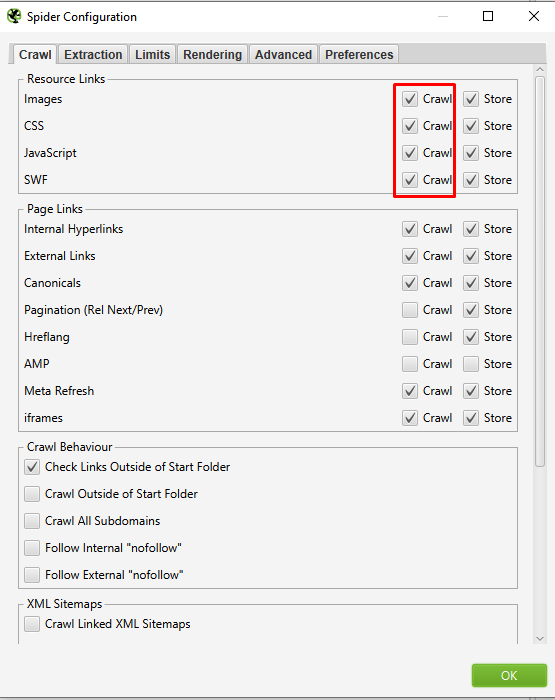

Широкий функционал утилиты Screaming Frog позволяет исключить из сканирования элементы сайта (картинки, JS, CSS и тд.).

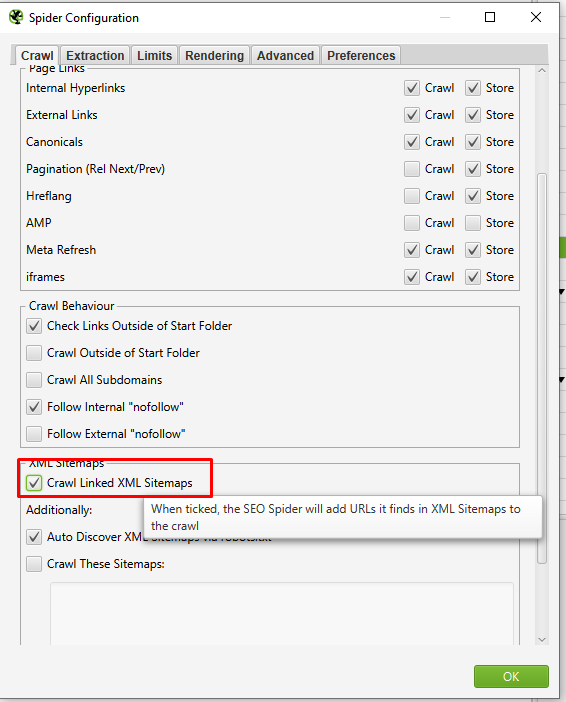

Если сайт мультиязычный, в конфигурации необходимо включить параметры Configuration - Spider - Crawl Linked XML Sitemap.

SPA сайти

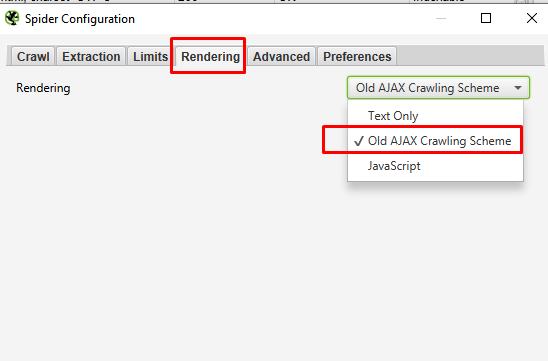

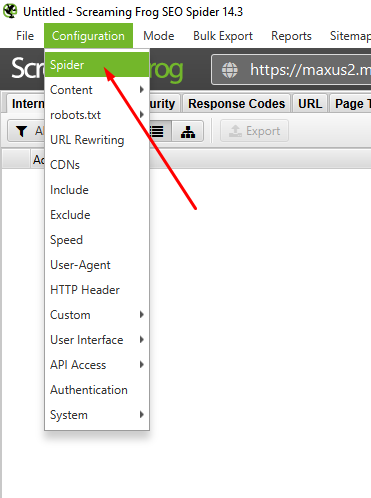

Отдельно стоит упомянуть парсинг SPA сайтов. При дефолтных настройках результатом будет только парсинг главного урла. Следует в Configuration — Spider во вкладке Rendering выбрать конфигурацию Old AJAX Crawling Scheme и запустить парсинг.

Закрытые от индексации сайты

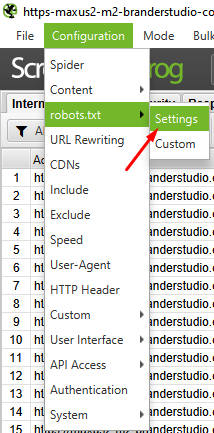

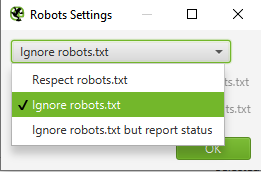

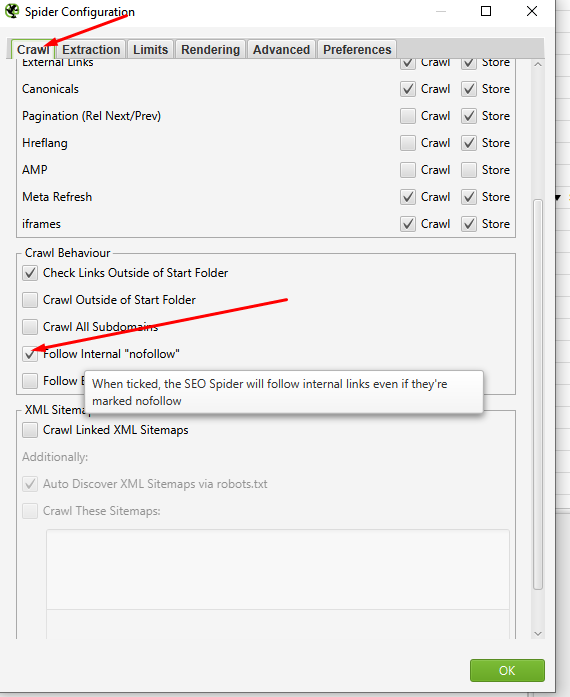

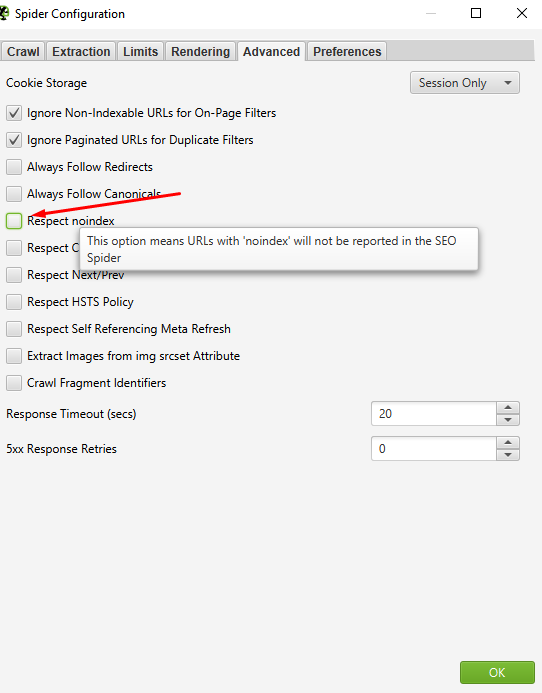

Есть пару моментов настройки парсинга для сайтов, закрытых от индексации. Необходимо “паука” направить по неиндексированным файлам. Открываем для robots.txt:

Затем в мета роботс:

И проверить отсутствие галки на Respect noindex:

Итак, завершили сканирование сайта. Что мы можем извлечь из результатов сканирования?

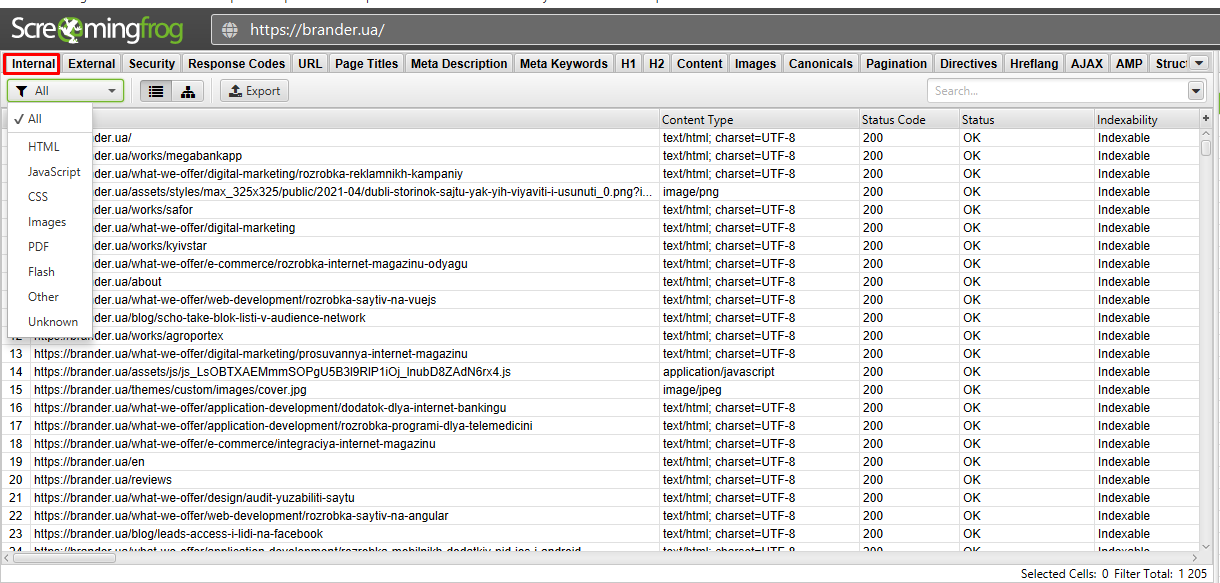

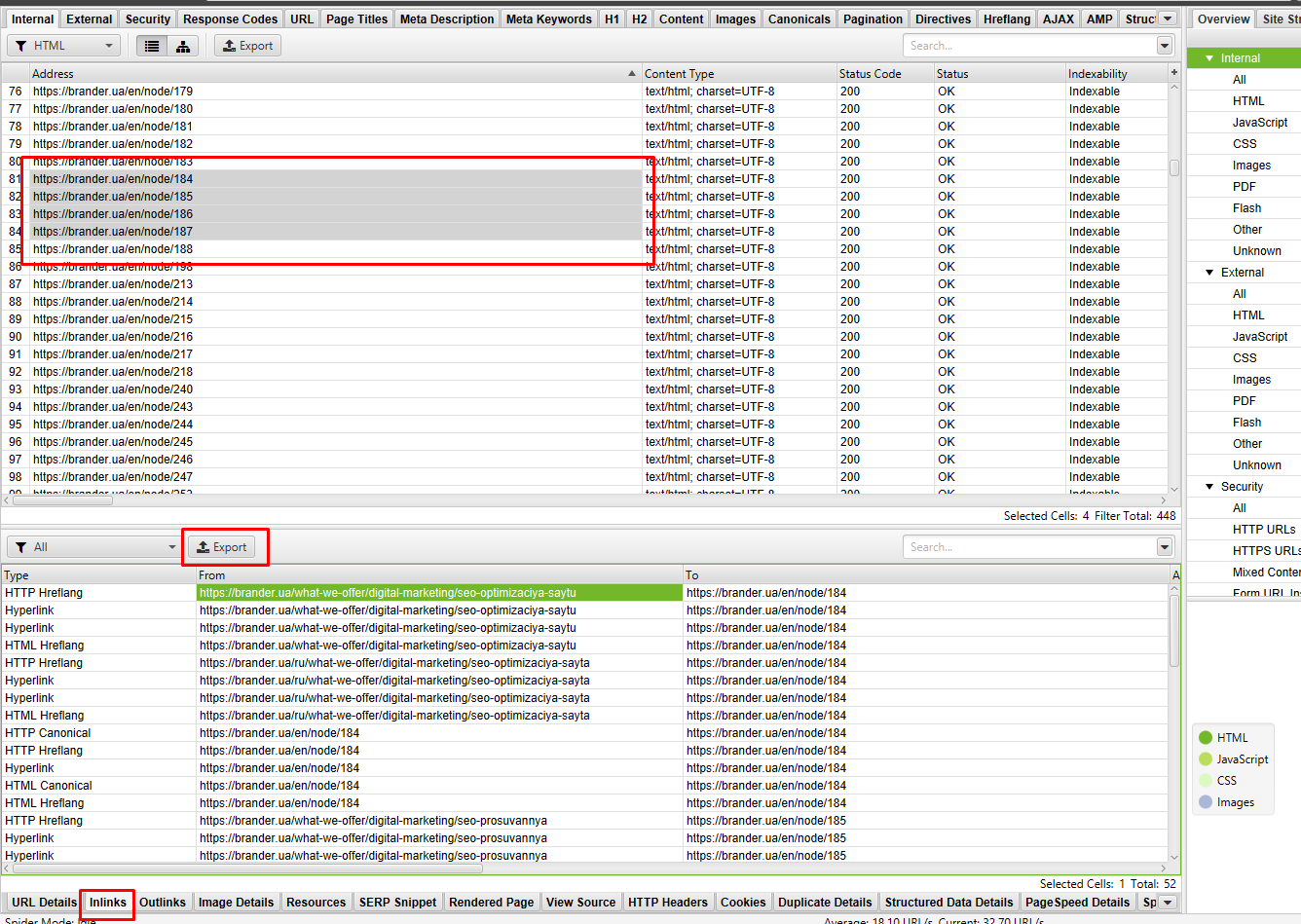

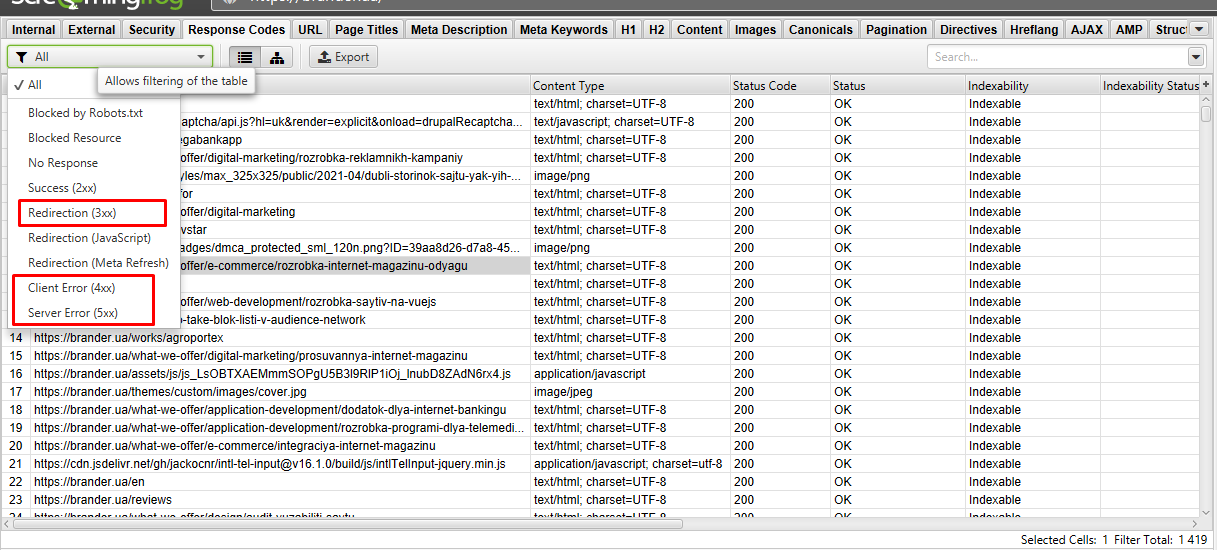

- Internal. В этой вкладке содержатся все внутренние ссылки сайта. Тут можем отсортировать URLs по коду ответа и отловить все битые ссылки и редиректы.

Во вкладке доступен фильтр (выбираем элемент сайта).

Ниже доступен подробный отчет.

Самое полезное в нем:

- Куда ссылка ведет и откуда. Выбрав урлы с ошибкой в подробном анализе, выгружаем данные. И получаем файл с местом расположения “некорректного” url.

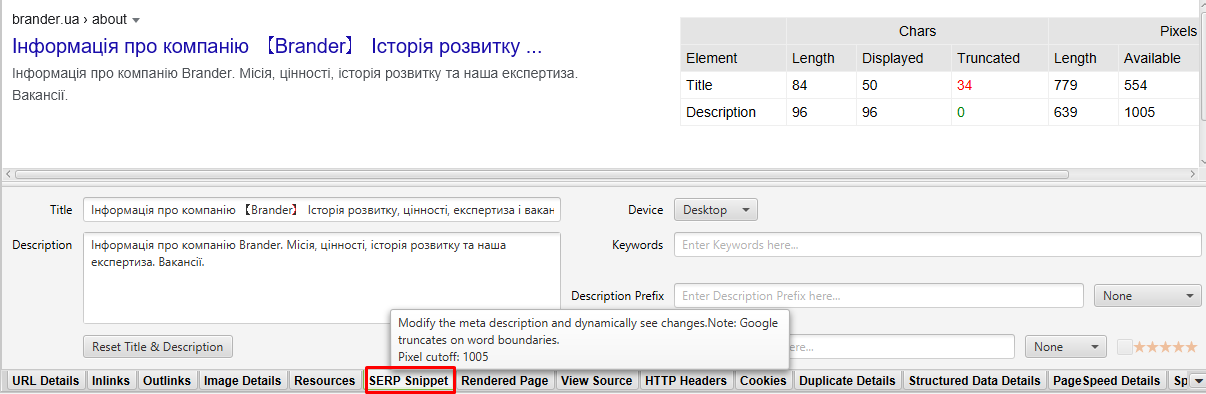

- Доступна визуализация мета текста в SERP.

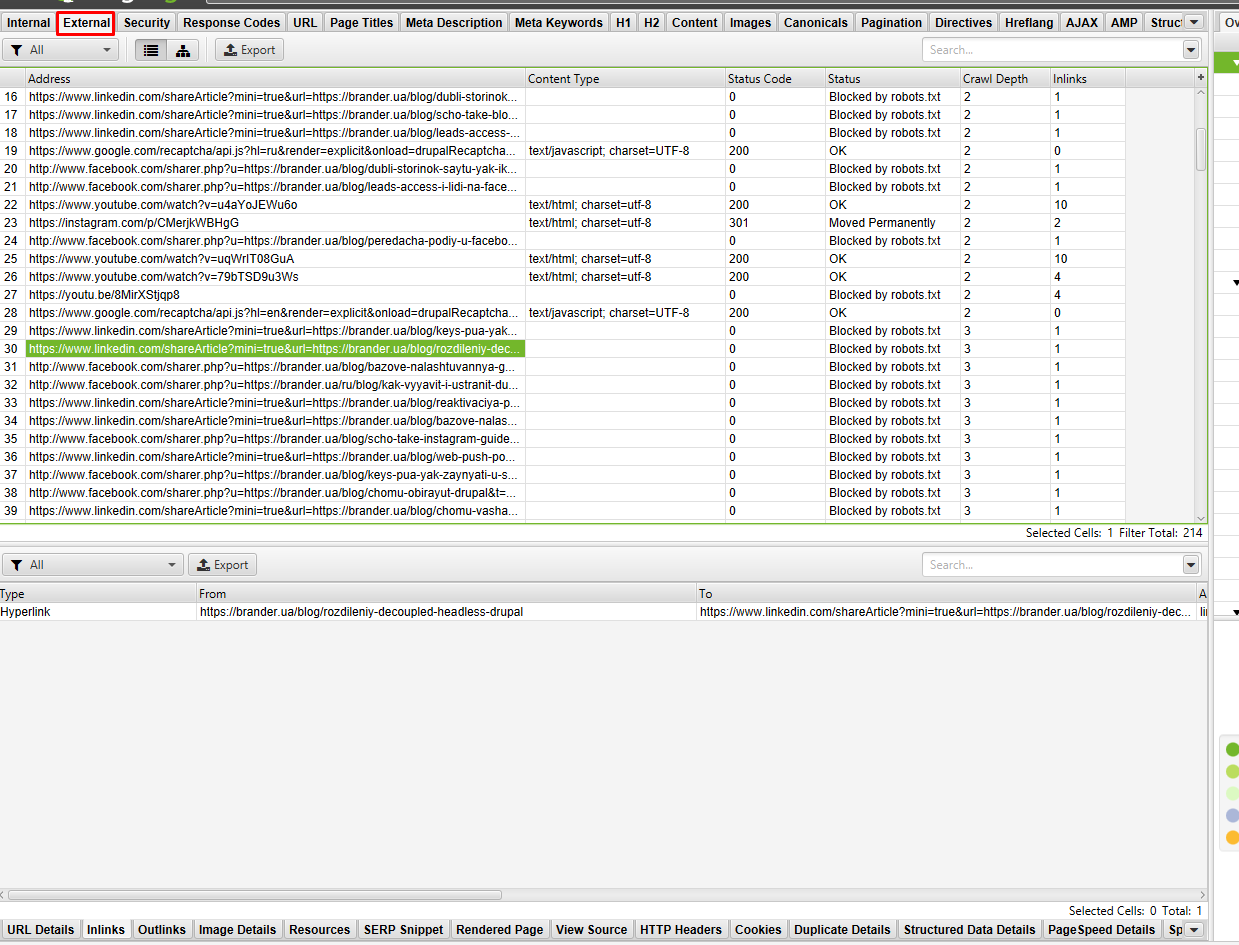

- External. Здесь найдете все внешние ссылки сканируемого сайта. По аналогии с внутренними отлавливаем код ответа и в доп. отчете смотрим, на какой странице сайта находятся ссылки с не 200 ответом, и составляем ТЗ на исправление.

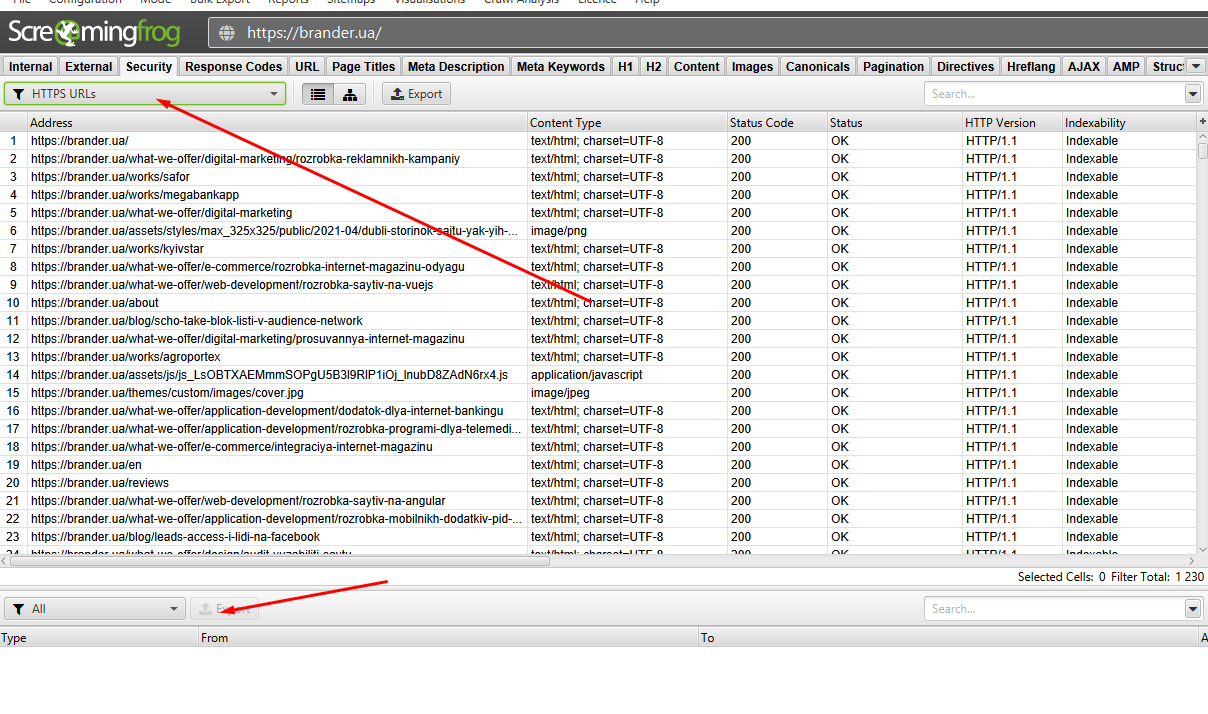

- Security. В этой вкладке отображаются данные, связанные с безопасностью внутренних URL-адресов сканируемого сайта (является ли URL индексируемым или неиндексируемым, и почему неиндексирован и тд). Смешанный контент — показывает любые HTML-страницы, загруженные через безопасное соединение HTTPS, которые имеют такие ресурсы как изображения, JavaScript или CSS, загружаемые через небезопасное соединение HTTP. Фильтр Http Urls выявит все http-URLs, выгружаем подробный отчет и избавляемся от всех небезопасных элементов сайта.

В моем случае таких страниц не обнаружено, поэтому кнопка экспорта не активна.

- Response code. Отчет по всем УРЛ, который можно отсортировать по коду ответа и загрузить в отчет для доработки все не 200 ответы.

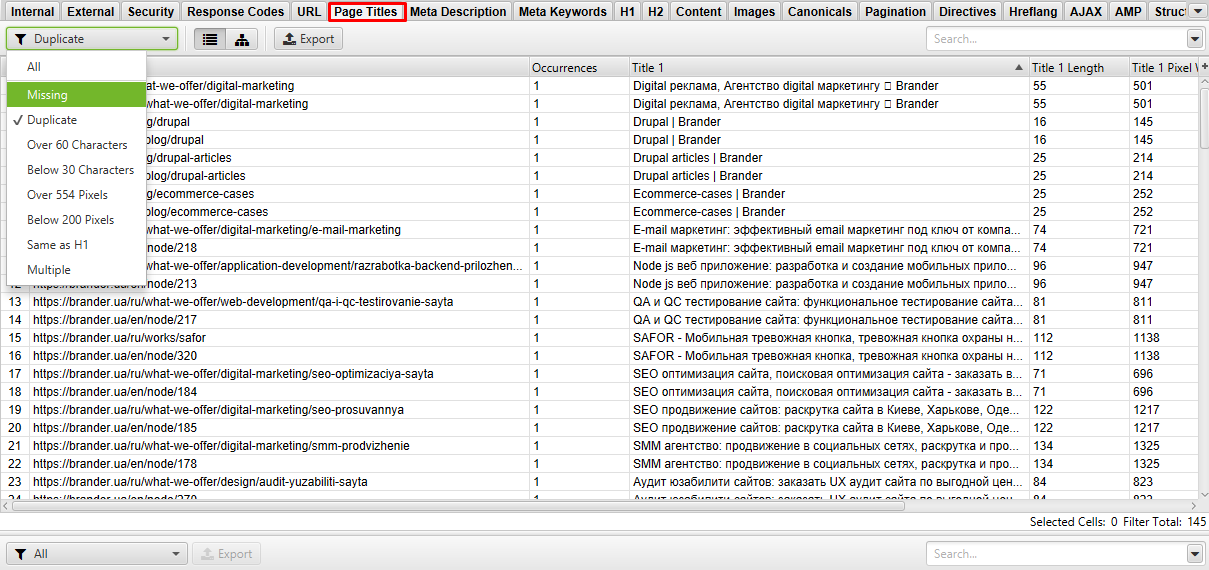

- Page Titles. Отчет в данной вкладке показывает, на каких страницах проставлен Title мета-текста, и где его нет. Выявляем дубли, слишком короткие/длинные заголовки.

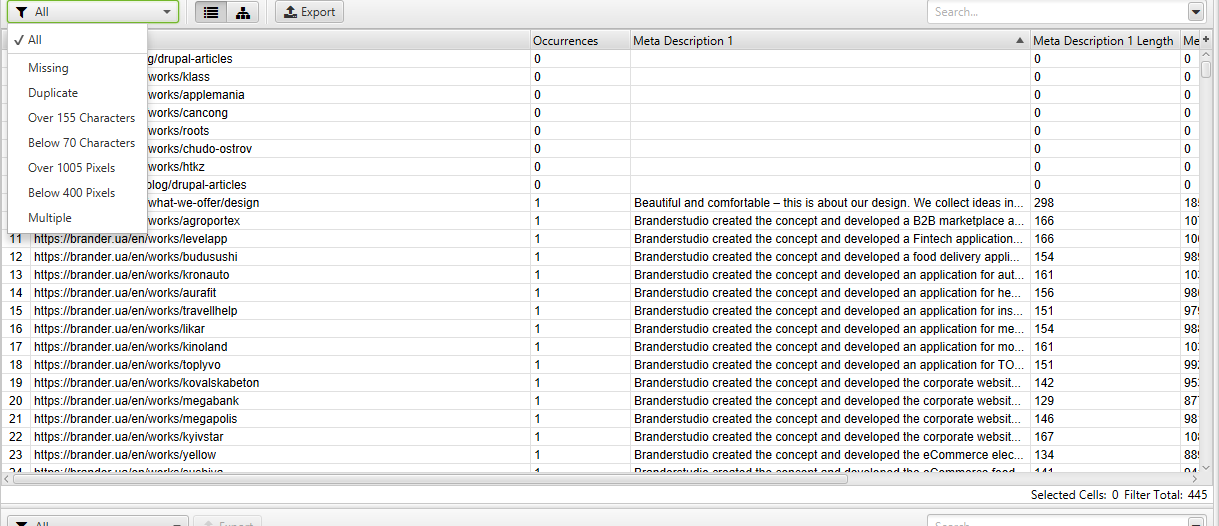

- Meta description. Тот же отчет, что и Page Titles, только для дискрипшена к странице. Находим дубли, длинные/короткие описания, отсутствующее, и оптимизируем.

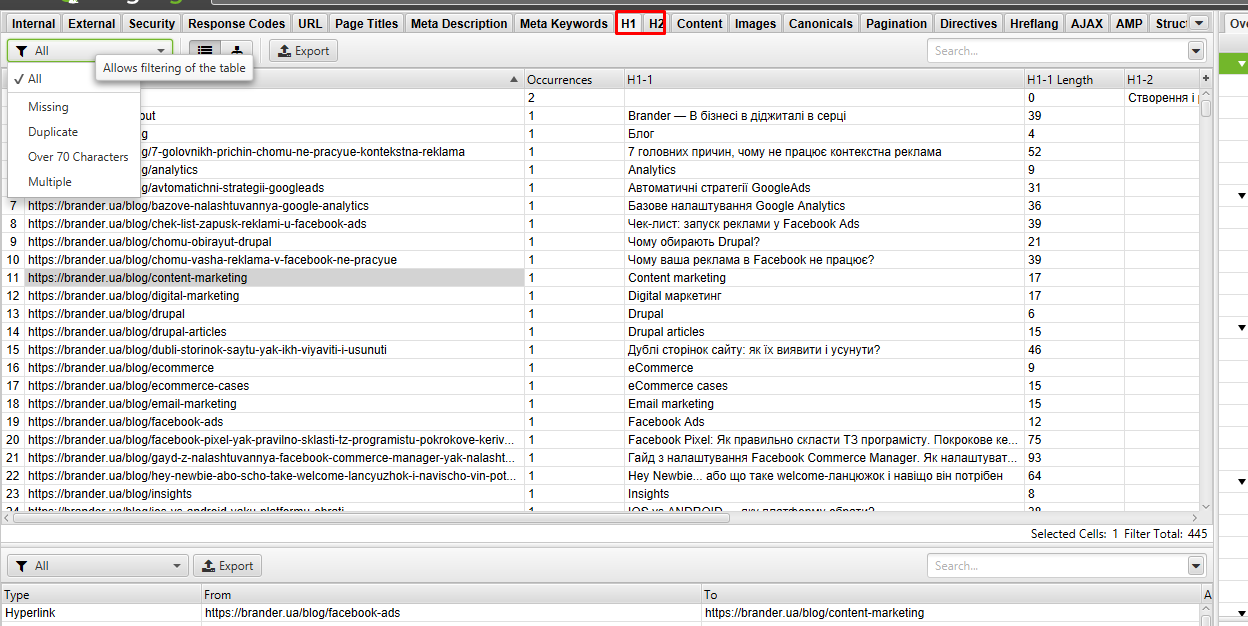

- H1 и H2. Позволяет найти страницы без заголовка или указывает их количество и длину на странице.

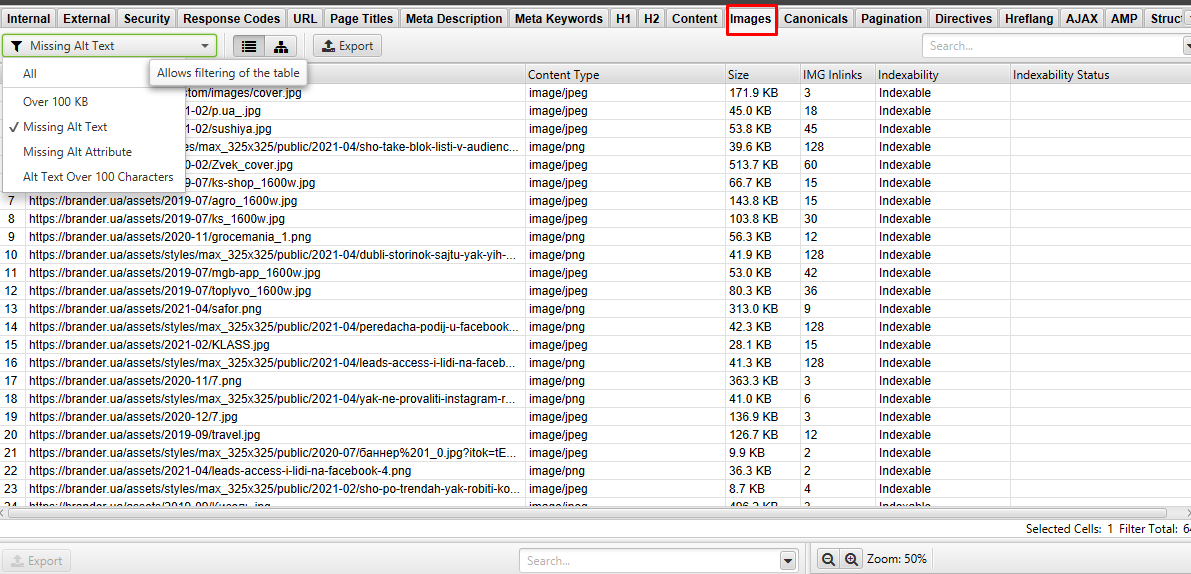

- Images. В этой вкладке анализируем размер изображений на сайте. С помощью фильтра “over 100 Kb” выгружаем в отчет картинки, которые необходимо сжать. Также в этой вкладке доступен анализ Alt-текста, где он пропущен, либо не присвоен атрибут альт.

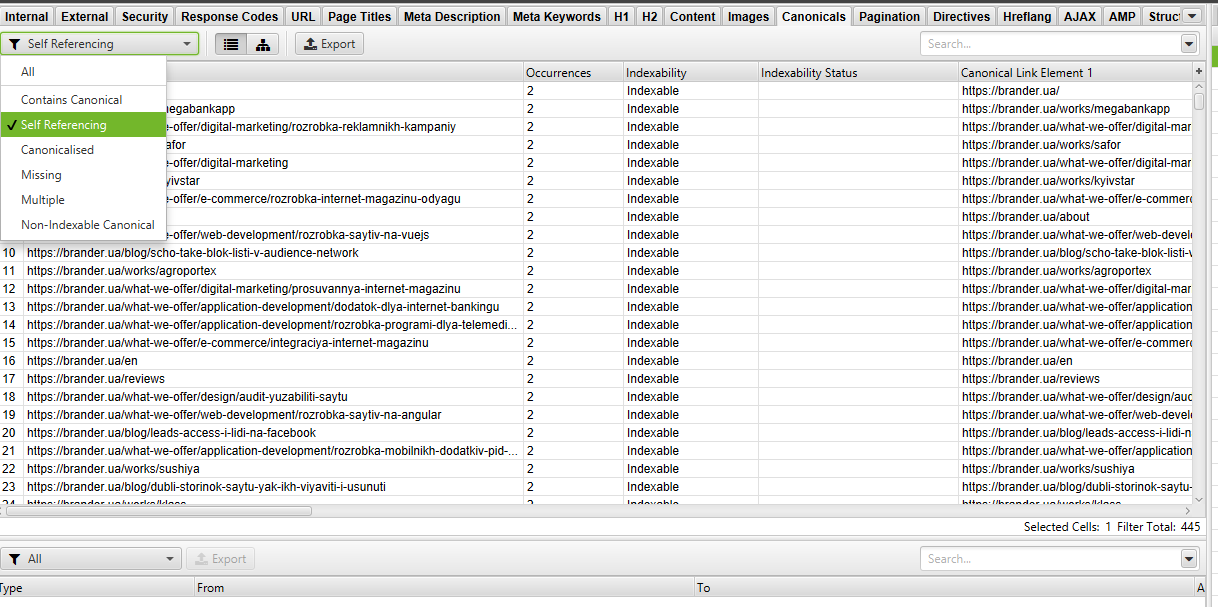

- Canonical. Отчет отображает канонические и нон-каноникал. В фильтре можно выбрать интересующие ошибки и сделать анализ, где проставить, а где изменить Canonical.

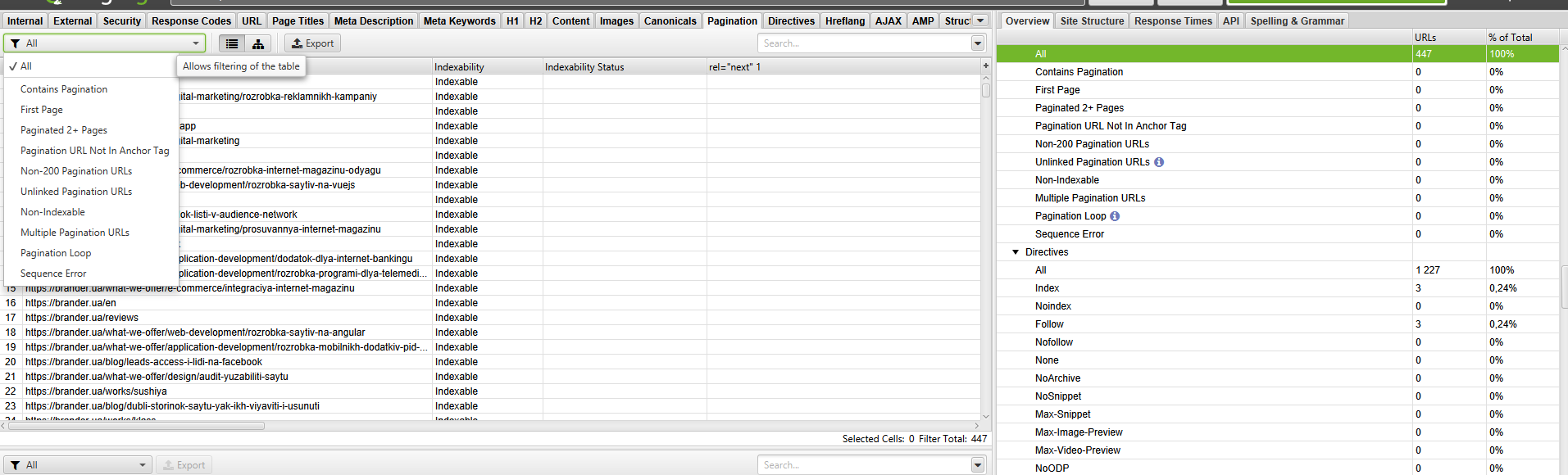

- Pagination. В этом разделе можно отловить все ошибки, связанные с пагинацией. Выявляет первые страницы пагинации с тегом rel = "prev", проверяет наличие этого тега во всех 2+ страницах, показывая, что страница не первая. Указывает URL-адрес разбиения на страницы с кодом ответа не 200. Выявляет несвязные адреса разбиения на страницы.

- Hreflang. Отображены ошибки с атрибутами hreflang (разные коды языка на одной странице и прочее, не 200 ответ сервера, страницы, на которых отсутствуют гиперссылки).

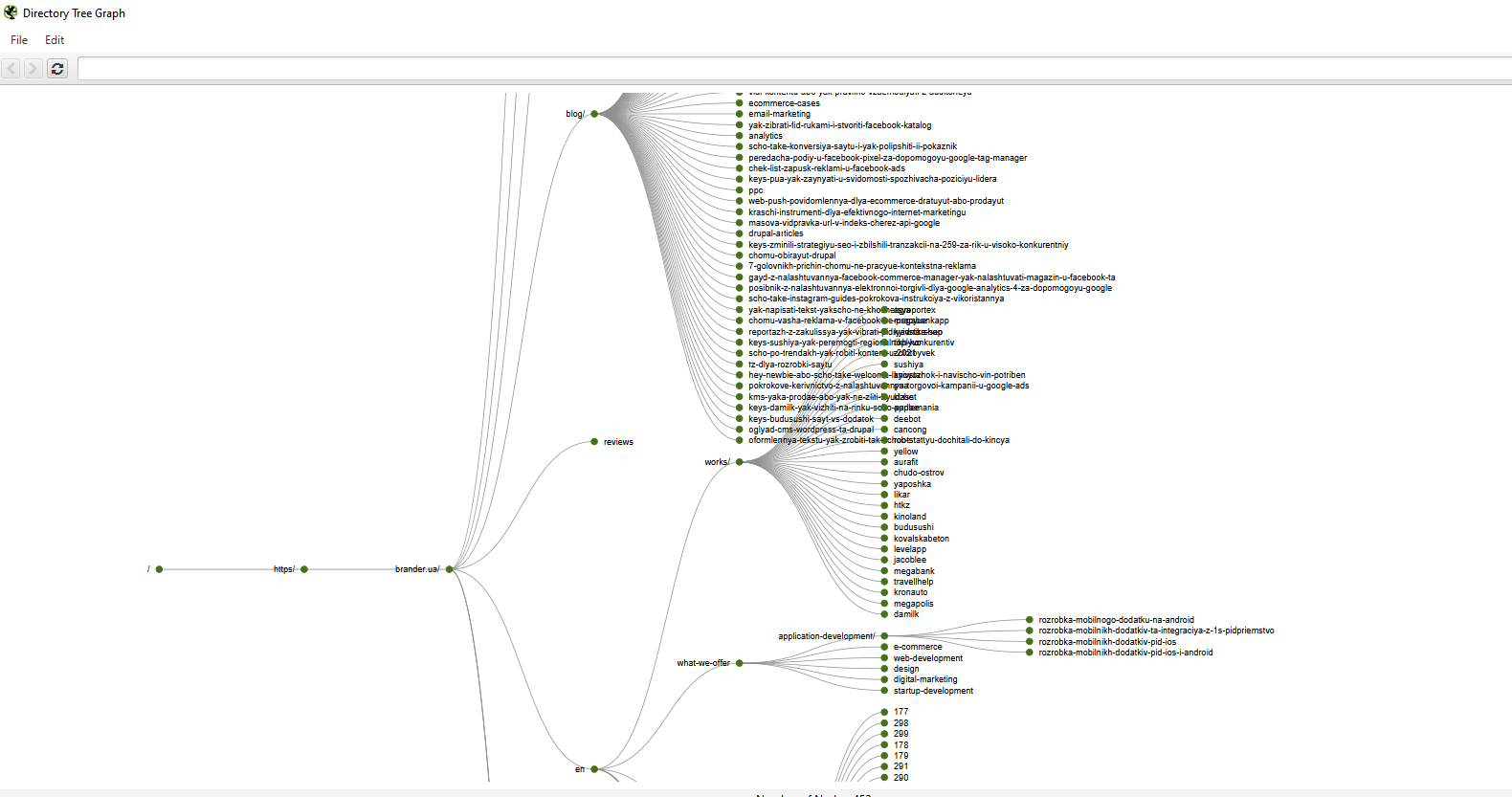

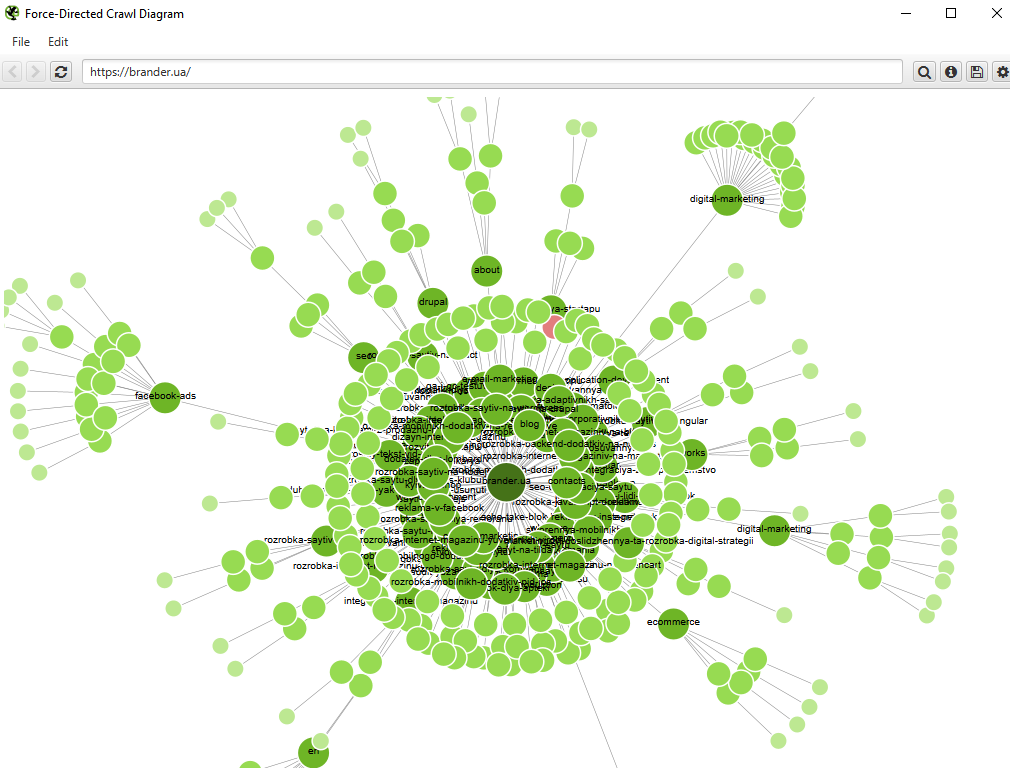

Функционал Screaming Frog позволяет получить визуальную структуру каталога сайта в виде графы или диаграммы.

Описывать все настройки парсинга программы SF можно долго, а и нужно ли? В этой статье рассказала обо всех самых частых и нужных настройках. В нишевых параметрах настройки можно покопаться после освоения базы утилиты. Надеюсь, было полезно. Успешных вам SEO-анализов и ТОПовых позиций в SERP!