Screaming Frog SEO Spider: аналіз результатів парсінгу

Успішний аудит сайту — це фундамент оптимізації SEO. У цій статті розберемо інструмент для проведення технічного SEO-аудиту сайту Screaming Frog. Розглянемо можливості програми, якими найчастіше користуюся при аудиті сайту.

Почнемо з завантаження програми.

Завантажити Screaming Frog можна на офіційному сайті www.screamingfrog.co.uk. Програма безплатна, але за повний функціонал доведеться заплатити. Безплатна версія включає скрімінг 500 Urls і не підтримує додаткові розширення.

За річну підписку на розширену версію доведеться витратити близько 6 тис. грн. Якщо ви SEO-фахівець, ця програма must-have на "Робочому столі", вона істотно полегшить і прискорить збір і аналіз технічних недоліків сайту.

Розбір функціоналу, яким найчастіше користуюся.

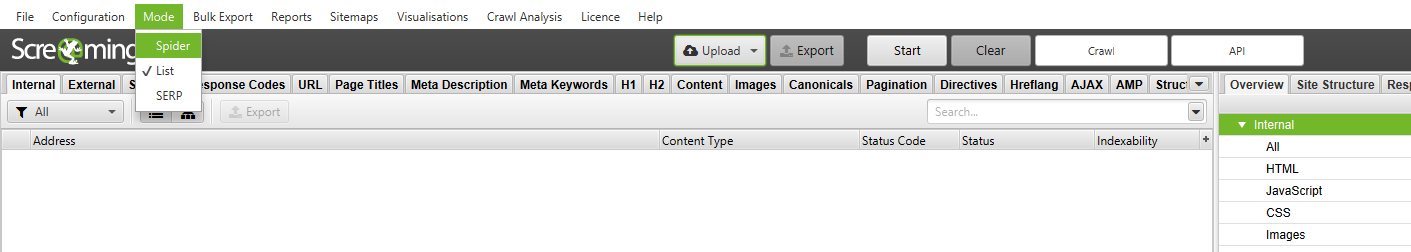

Скрімінг фрог дозволяє сканувати сайт декількома способами:

- Spider:

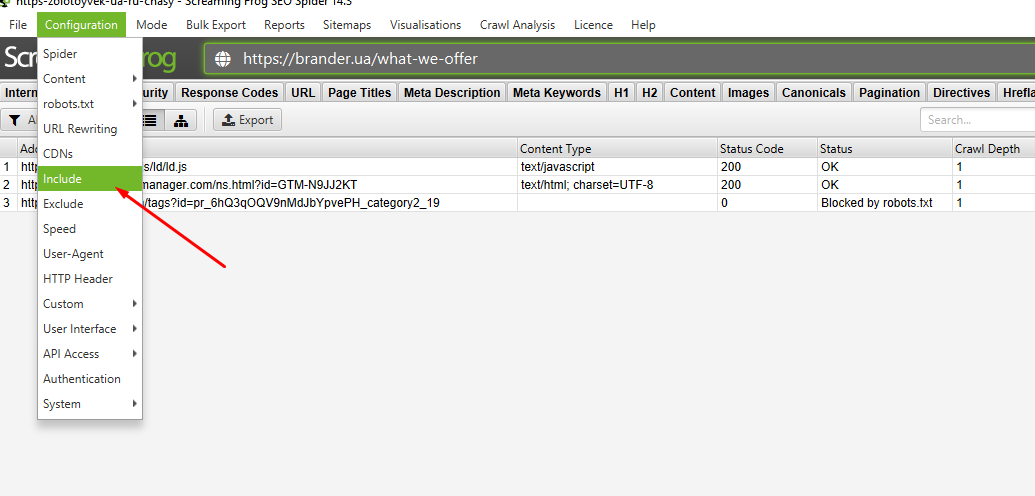

Сканування всього сайту, програм ходить по всім URLs ресурсу. Це дає повний аналіз сайту і дозволяє виявити всі "биті" посилання. У методу є недолік, який полягає в тому, що якщо у сайту пошкоджені JS-скрипти або проблеми з пагінацією, сканування може піти в нескінченний цикл. Що ж робити? Вихід є, за допомогою конфігурації Include або Extend можна позначити розділ, що парсінгуємо, або виключити відповідно. Наприклад:

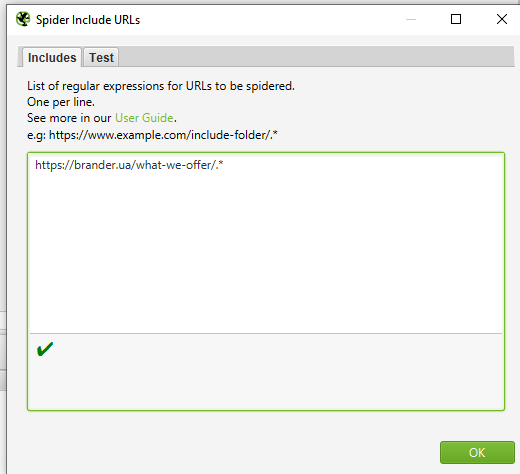

Є завдання спарсити розділ сайту brander.ua/what-we-offer. Для цього я додаю правило в Configuration — Include.

Потім за допомогою регулярного виразу (синтаксис вказано у вікні) вводжу потрібний для сканування розділ.

Старт і вуаля. Ми просканували тільки окрему категорію на сайті. Бувають ситуації, коли необхідні для сканування сторінки не лежать в будь-якій вкладеності, а просканувати сайт повністю немає можливості по ряду причин (об'єм сайту, ламаний js тощо). Тоді діємо від зворотного. Можна внести в виключення Extend всі категорії, що істотно зменшить кількість урлів, і успішно спарсити залишок.

- List:

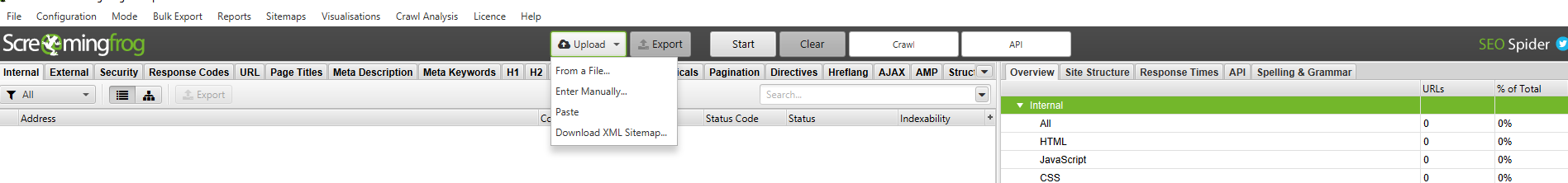

Сканування сайту за списком URLs. Список необхідних для сканування сторінок ви можете вставити як файлом, так і мануально. У сканування List також є недолік. Якщо є список урлів, і хочеш спарсити тільки зовнішні посилання, то у звіті лист зробити цього не можна. Даний метод парсить тільки конкретні URL і не проходиться по ньому "павуком".

Є можливість просканувати SiteMap. Це дозволяє знаходити помилки на проіндексованих сторінках.

- SERP:

Цей режим не сканує сайт, а створений для роботи з мета-текстами. Можна завантажити позначки, редагувати й переглядати, як вони показуються в браузері.

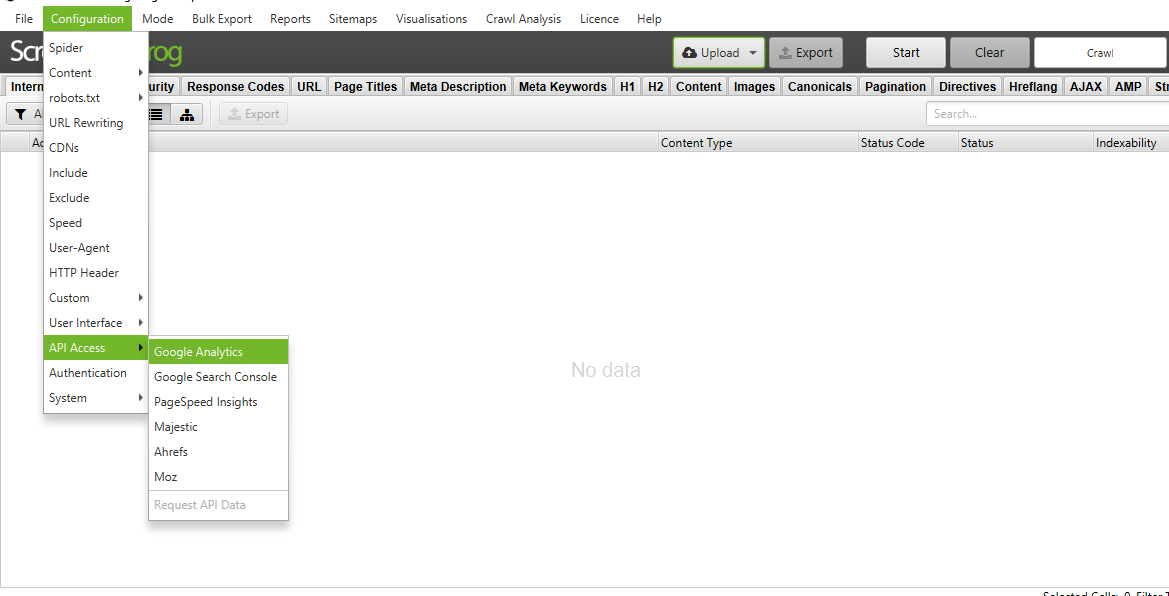

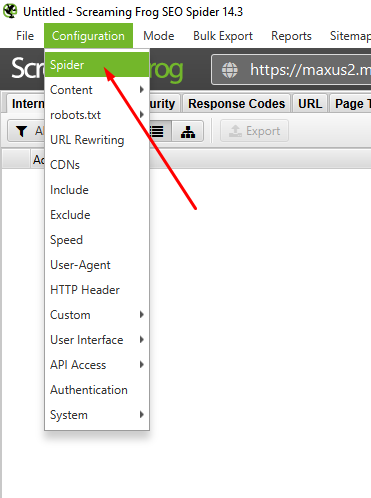

Перед початком сканування сайту рекомендую увімкнути аналітику, що дозволить не робити окремих аналізів по всіх сервісах, а вивантажити все і відразу. Доступна аналітика по Google Analytics, Search Console, Moz, Pagespeed, Ahrefs, Majestiks. Це можна зробити за допомогою вкладки Configuration — API Access.

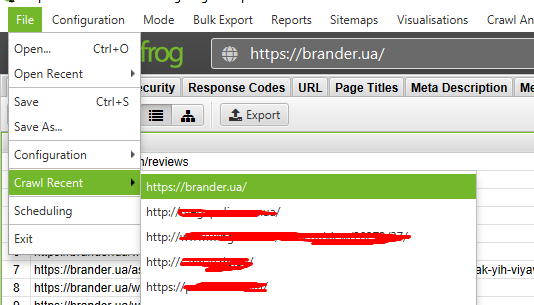

Історія парсінгу знаходиться у вкладці File — Craw Resent.

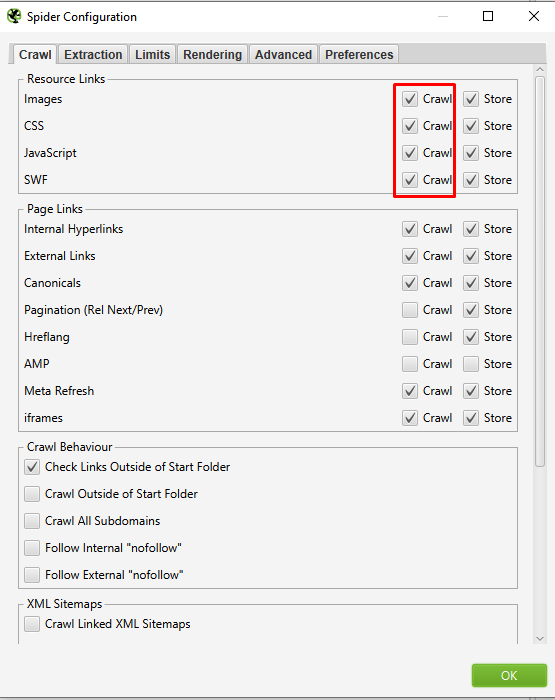

Широкий функціонал утиліти Screaming Frog дозволяє виключити зі сканування елементи сайту (картинки, JS, CSS тощо).

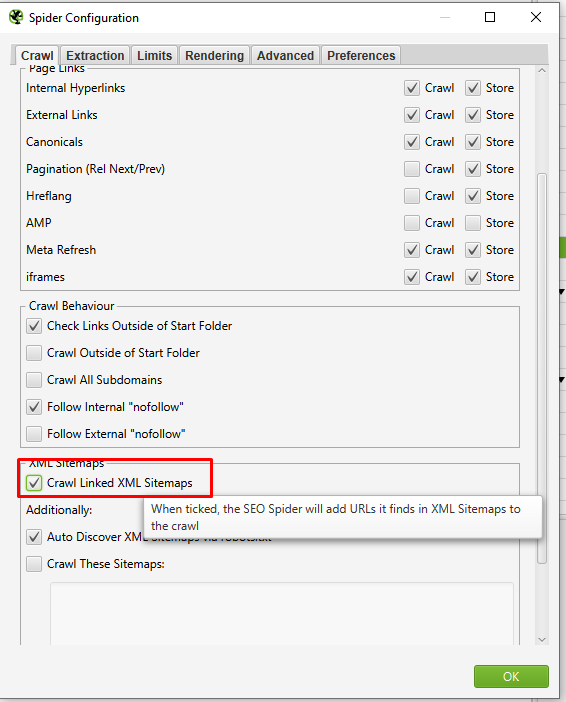

Якщо сайт багатомовний, в конфігурації потрібно ввімкнути установку Configuration - Spider - Crawl Linked XML Sitemap.

SPA сайти

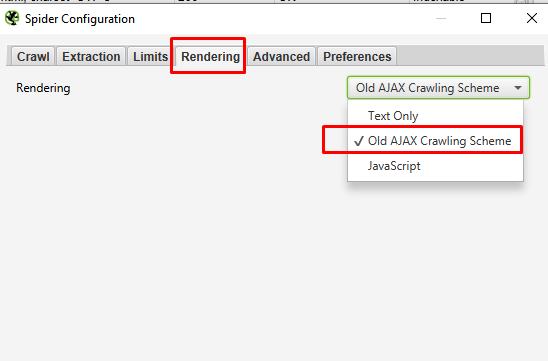

Окремо варто згадати парсінг SPA сайтів. При дефолтних налаштуваннях результатом буде лише парсінг головного урла. Слід в Configuration — Spider у вкладці Rendering вибрати конфігурацію Old AJAX Crawling Scheme і запустити парсінг.

Закриті від індексації сайти

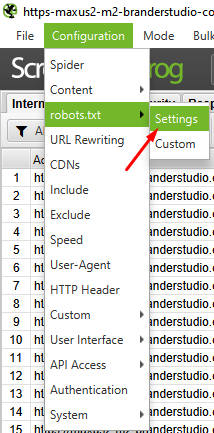

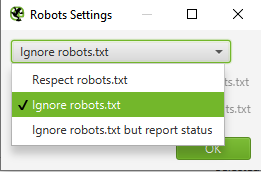

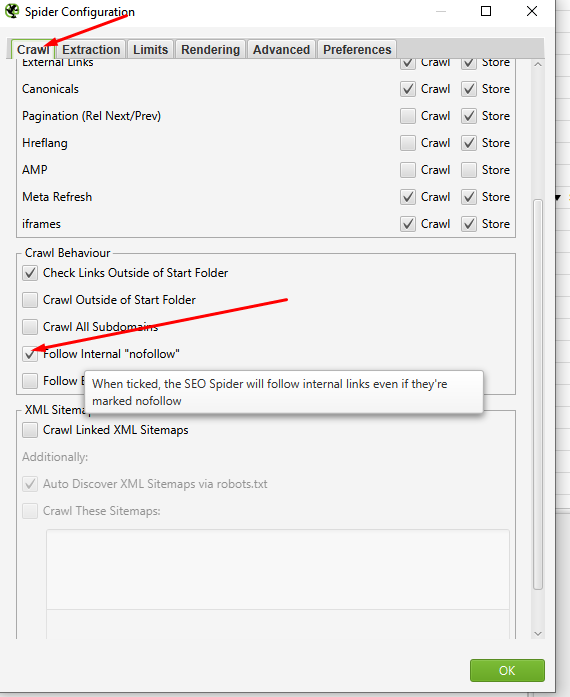

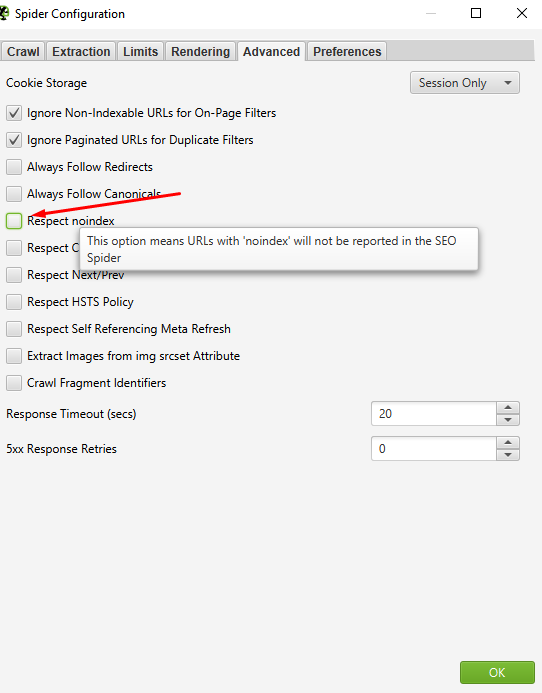

Є пару моментів налаштування парсінгу для сайтів, закритих від індексації. Необхідно "павука" направити по неіндексованих файлів. Відкриваємо для robots.txt:

Потім в мета роботс

І перевірити відсутність галки на Respect noindex:

Отже, завершили сканування сайту. Що ми можемо витягти з результатів сканування?

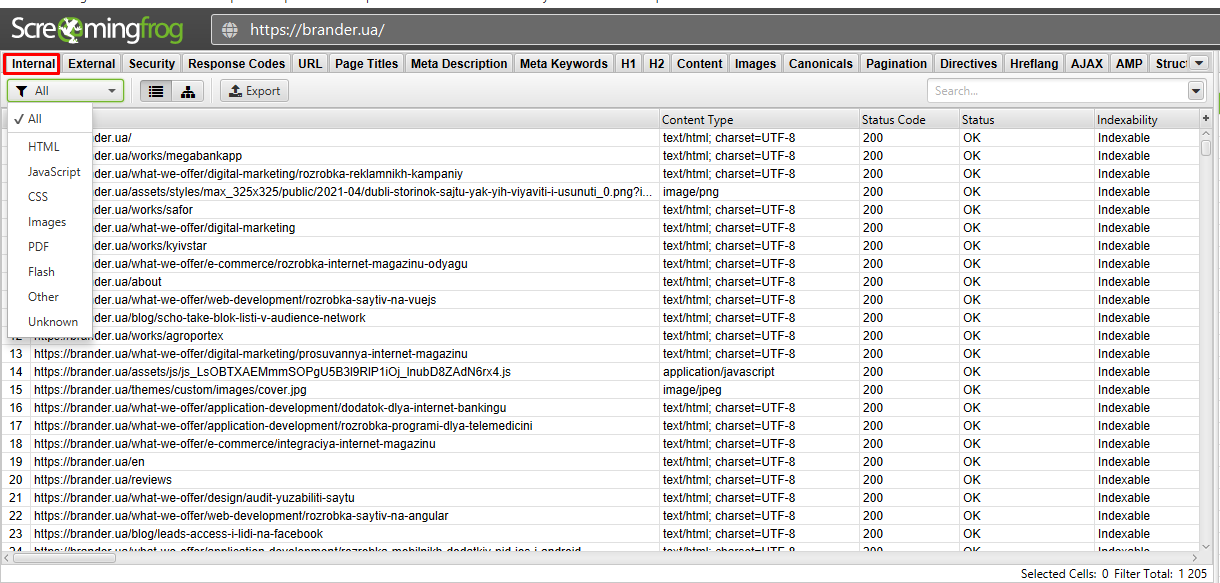

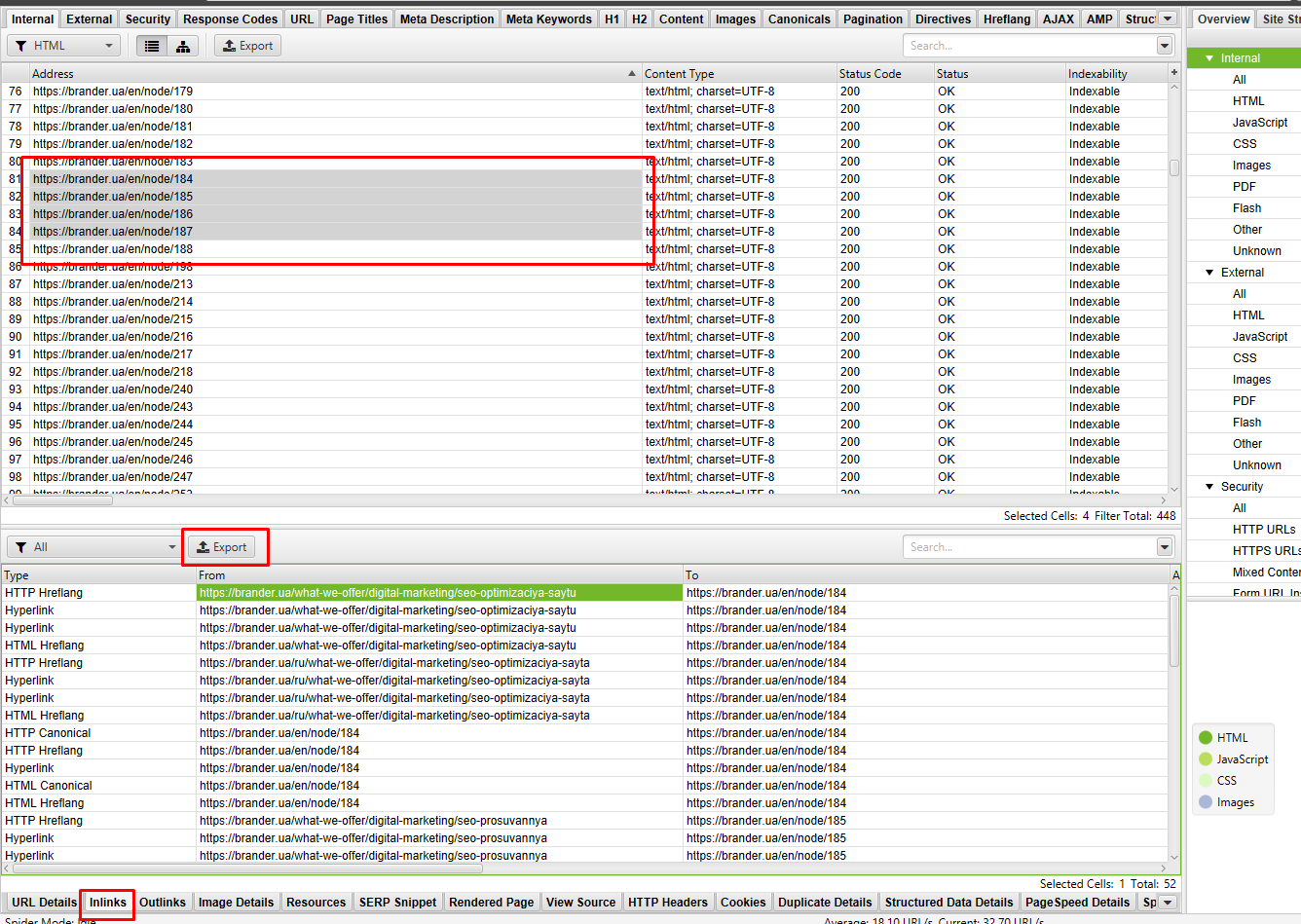

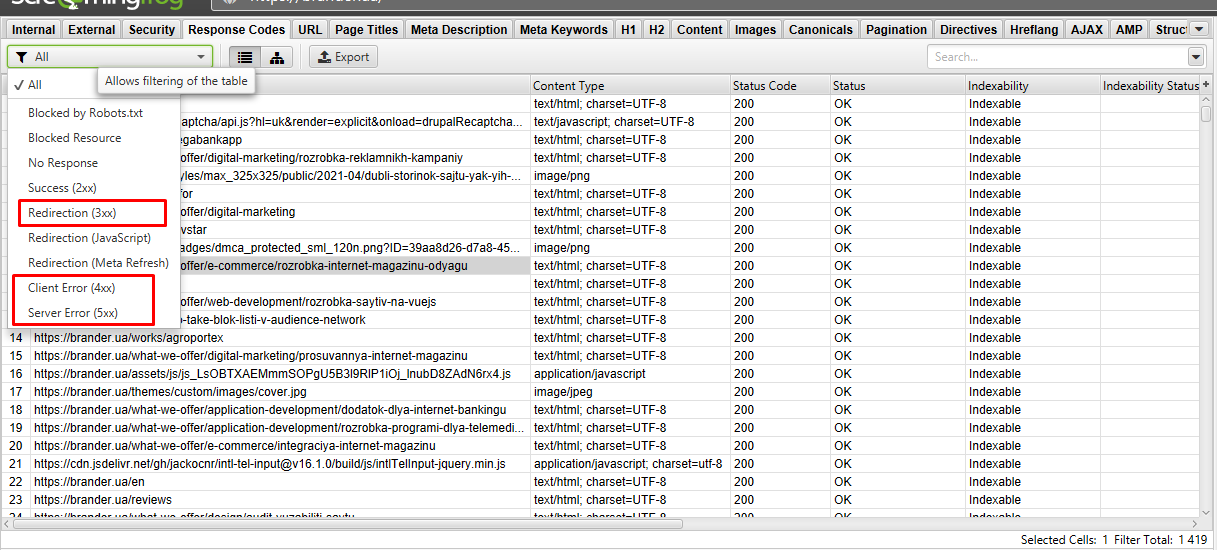

- Internal. У цій вкладці містяться всі внутрішні посилання сайту. Тут можемо впорядкувати URLs за кодом відповіді й відловити всі биті посилання і редіректи.

У вкладці доступний фільтр (вибираємо елемент сайту).

Нижче доступний докладний звіт.

Найкорисніше в ньому:

- Куди посилання веде і звідки. Вибравши урли з помилкою в докладному аналізі, вивантажуємо дані. І отримуємо файл з місцем розташування "некоректного" url.

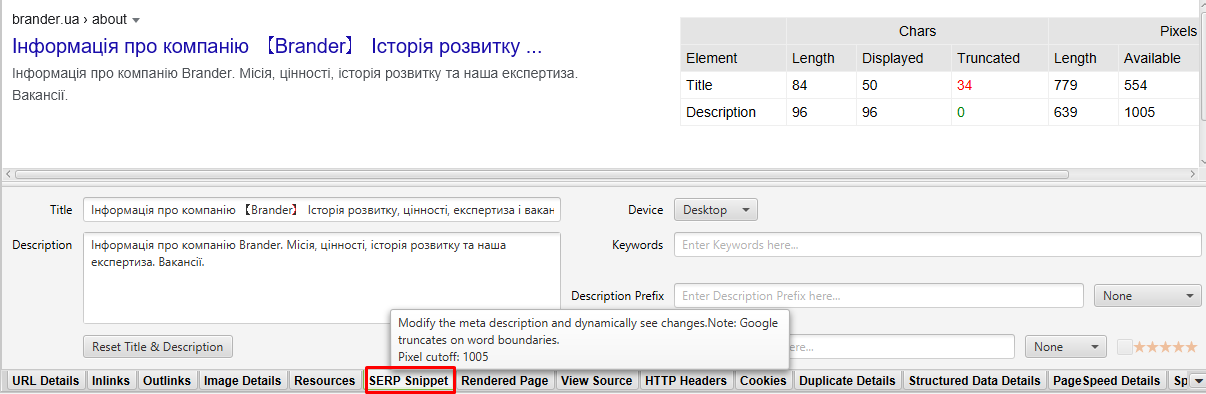

- Доступна візуалізація мета тексту в SERP.

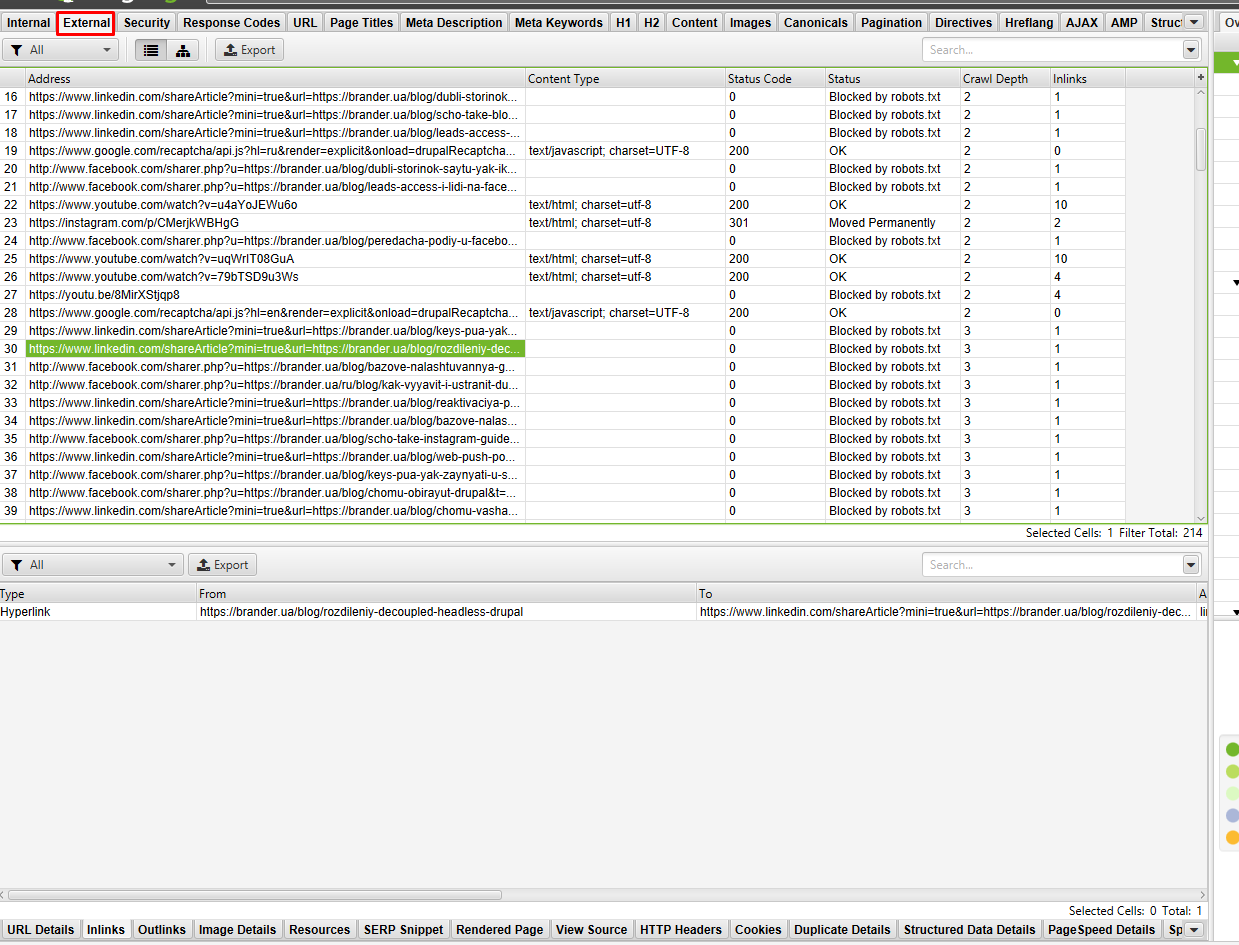

- External. Тут знайдете всі зовнішні посилання сайту, що скануються. За аналогією з внутрішніми відловлюємо код відповіді й в доп. звіті дивимося, на якій сторінці сайту можна знайти посилання з не 200 відповіддю, і складаємо ТЗ на виправлення.

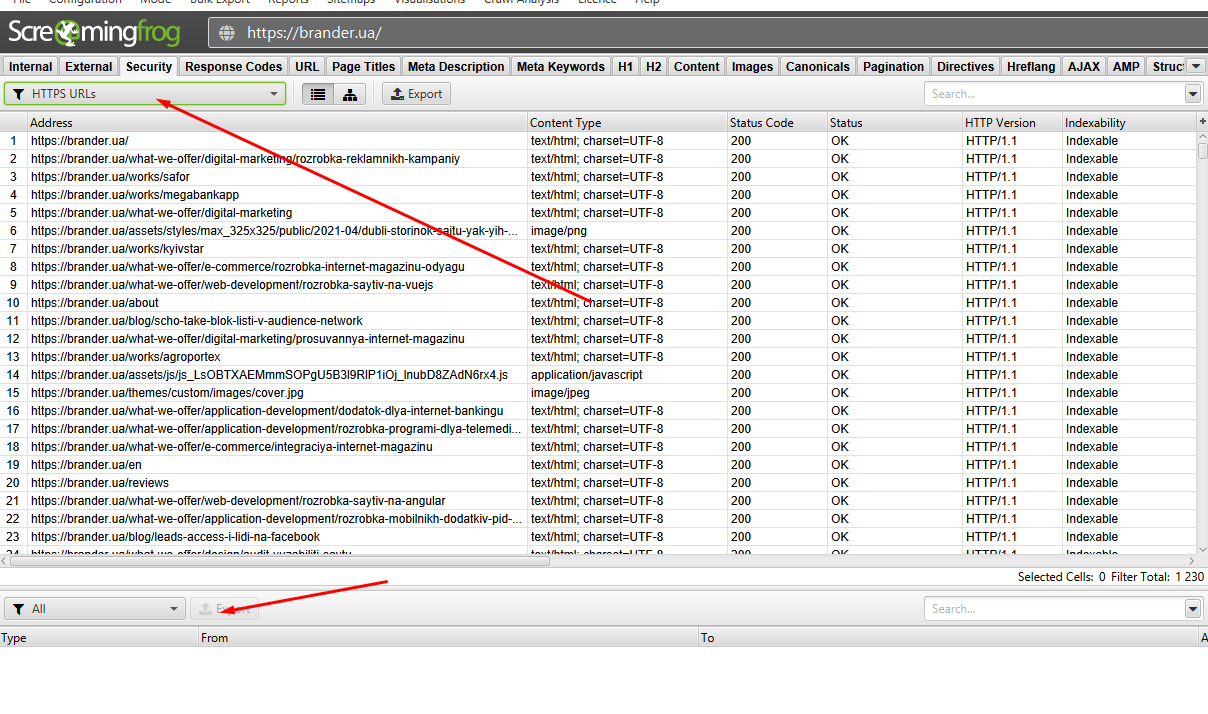

- Security. У цій вкладці показуються дані, пов'язані з безпекою внутрішніх URL-адрес сайту, що сканується (чи URL індексований або неіндексований, і чому неіндексований тощо). Змішаний контент — показує будь-які HTML-сторінки, завантажені через безпечне з'єднання HTTPS, які мають такі ресурси як зображення, JavaScript або CSS, що завантажуються через небезпечне з'єднання HTTP. Фільтр Http Urls виявить всі http-URLs, вивантажуємо докладний звіт і позбавляємося від усіх небезпечних елементів сайту.

У моєму випадку таких сторінок не виявлено, тому кнопка експорту не активна.

- Response code. Звіт по всім УРЛ, який можна відсортувати за кодом відповіді й завантажити у звіт для доопрацювання всі не 200 відповіді.

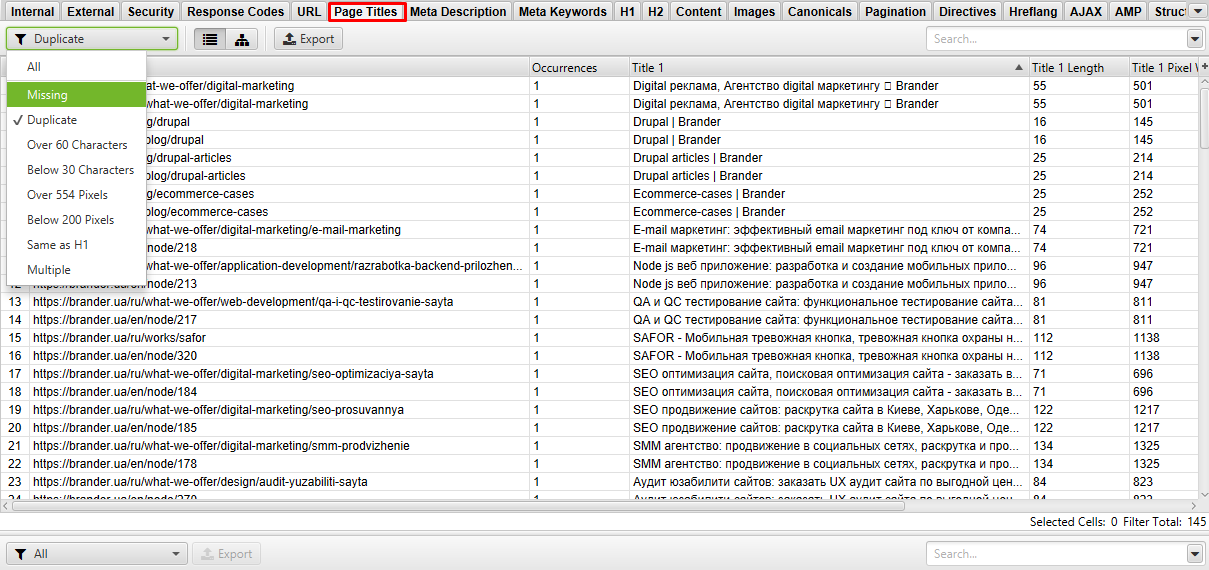

- Page Titles. Звіт в даній вкладці показує, на яких сторінках проставлений Title мета-тексту, і де його немає. Виявляємо дублі, занадто короткі/довгі заголовки.

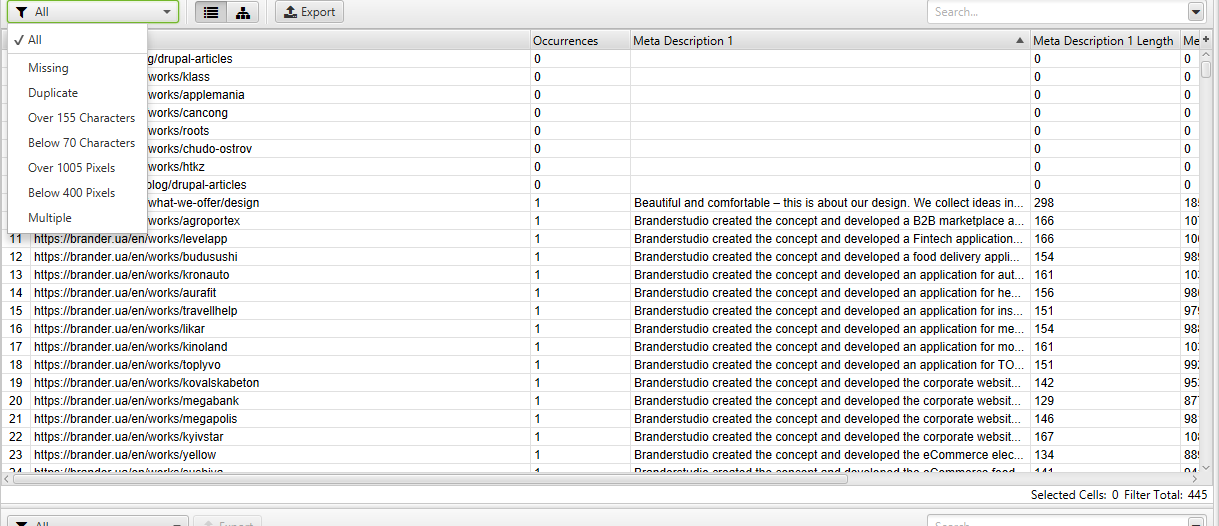

- Meta description. Той же звіт, що і Page Titles, тільки для діскріпшена на сторінку. Знаходимо дублі, довгі/короткі описи, відсутнє, і оптимізуємо.

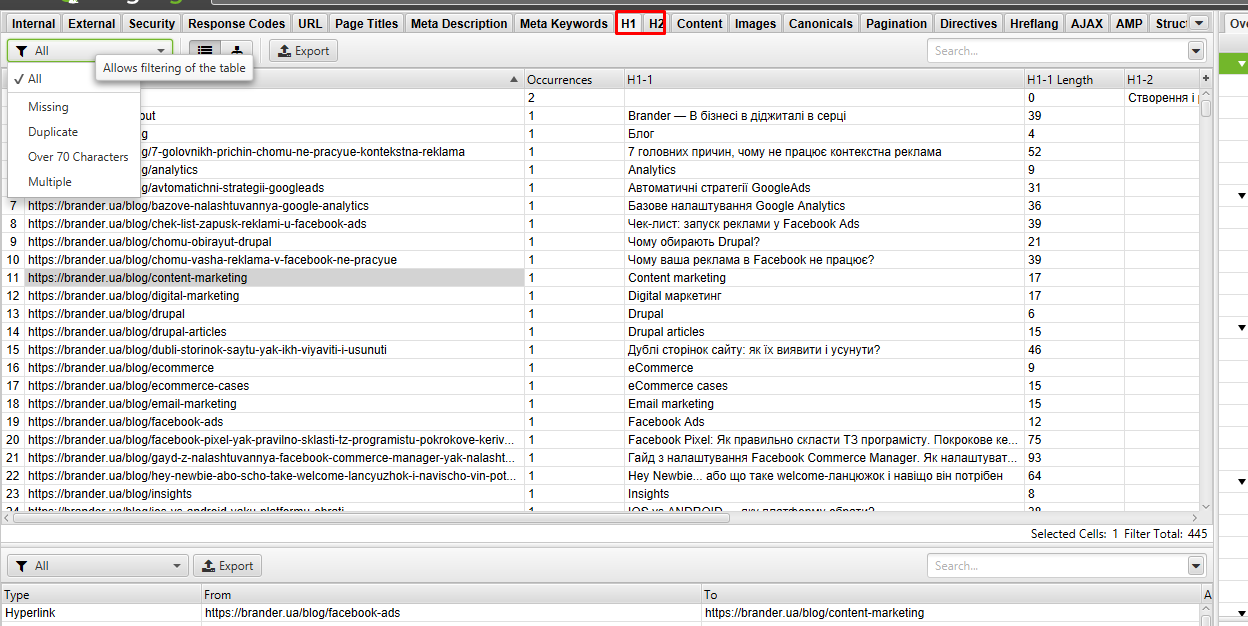

- H1 і H2. Дозволяє знайти сторінки без заголовка або вказує їх кількість і довжину на сторінці.

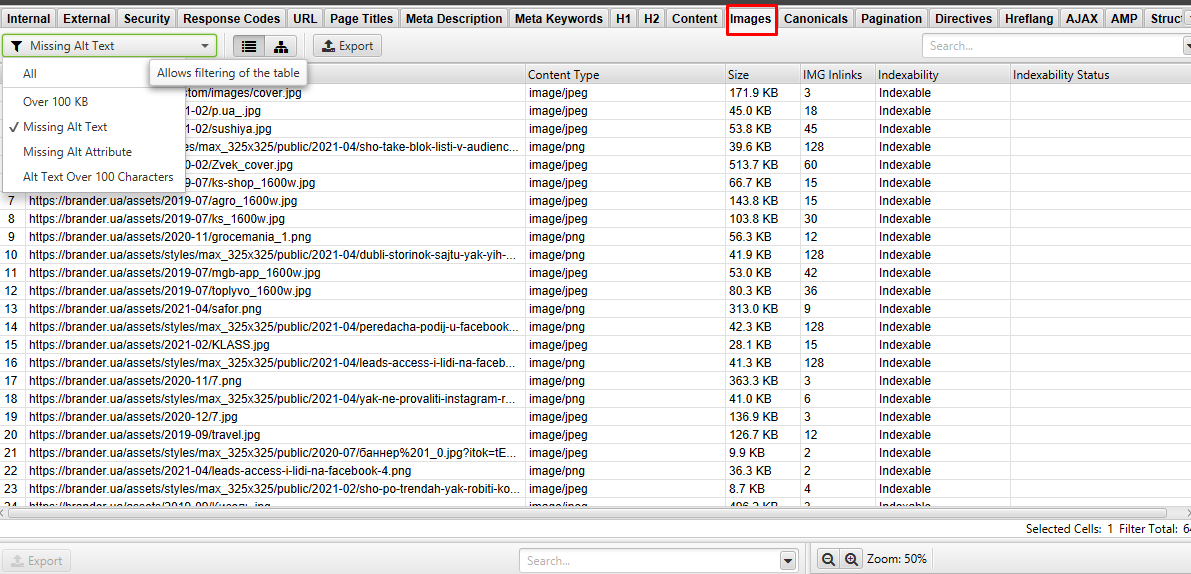

- Images. У цій вкладці аналізуємо розмір зображень на сайті. За допомогою фільтра "over 100 Kb" вивантажуємо у звіт картинки, які необхідно стиснути. Також в цій вкладці доступний аналіз Alt-тексту, де його пропущено, або не присвоєно атрибут альт.

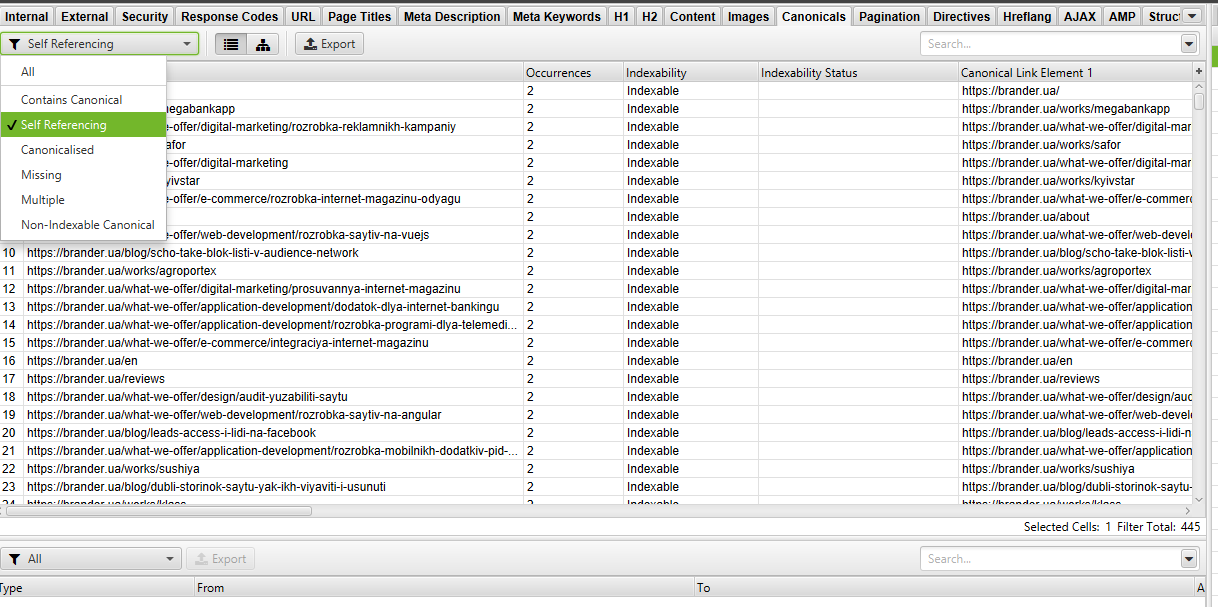

- Canonical. Звіт показує канонічні й нон-канонікал. У фільтрі можна вибрати помилки, що цікавлять, й зробити аналіз, де проставити, а де змінити Canonical.

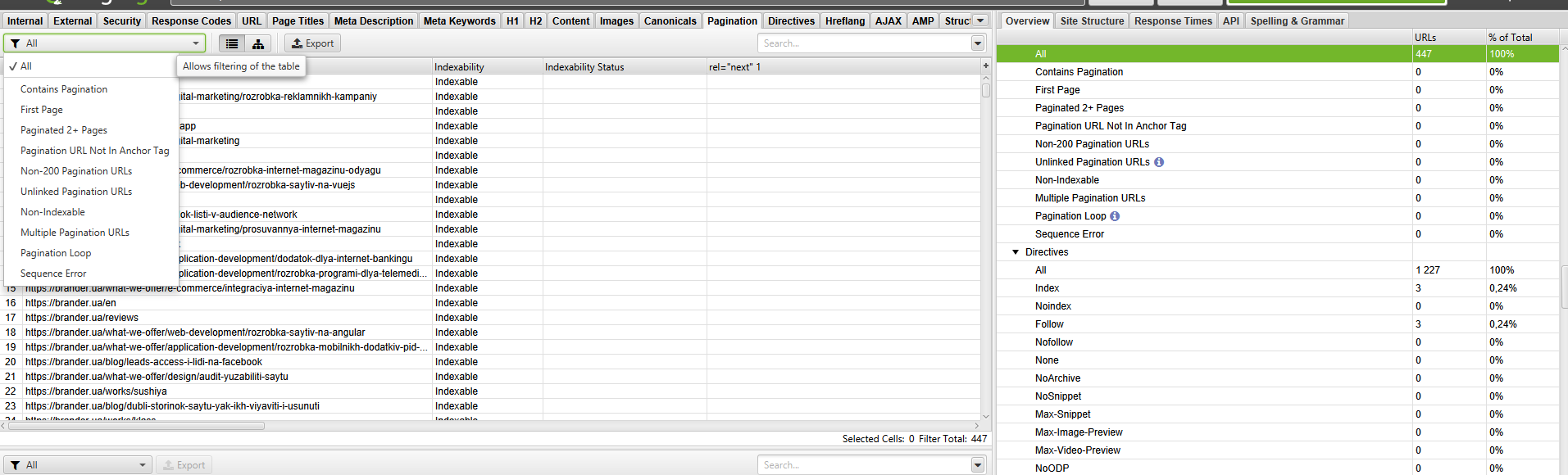

- Pagination. У цьому розділі можна відловити всі помилки, пов'язані з пагінацією. Виявляє перші сторінки пагінації з тегом rel = "prev", перевіряє наявність цього тега в усіх 2+ сторінках, показуючи, що сторінка не перша. Вказує URL-адресу розбиття на сторінки з кодом відповіді не 200. Виявляє незв'язні адреси розбиття на сторінки.

- Hreflang. Показані помилки з атрибутами hreflang (різні коди мови на одній сторінці та інше, не 200 відповідь сервера, сторінки, на яких відсутні гіперпосилання).

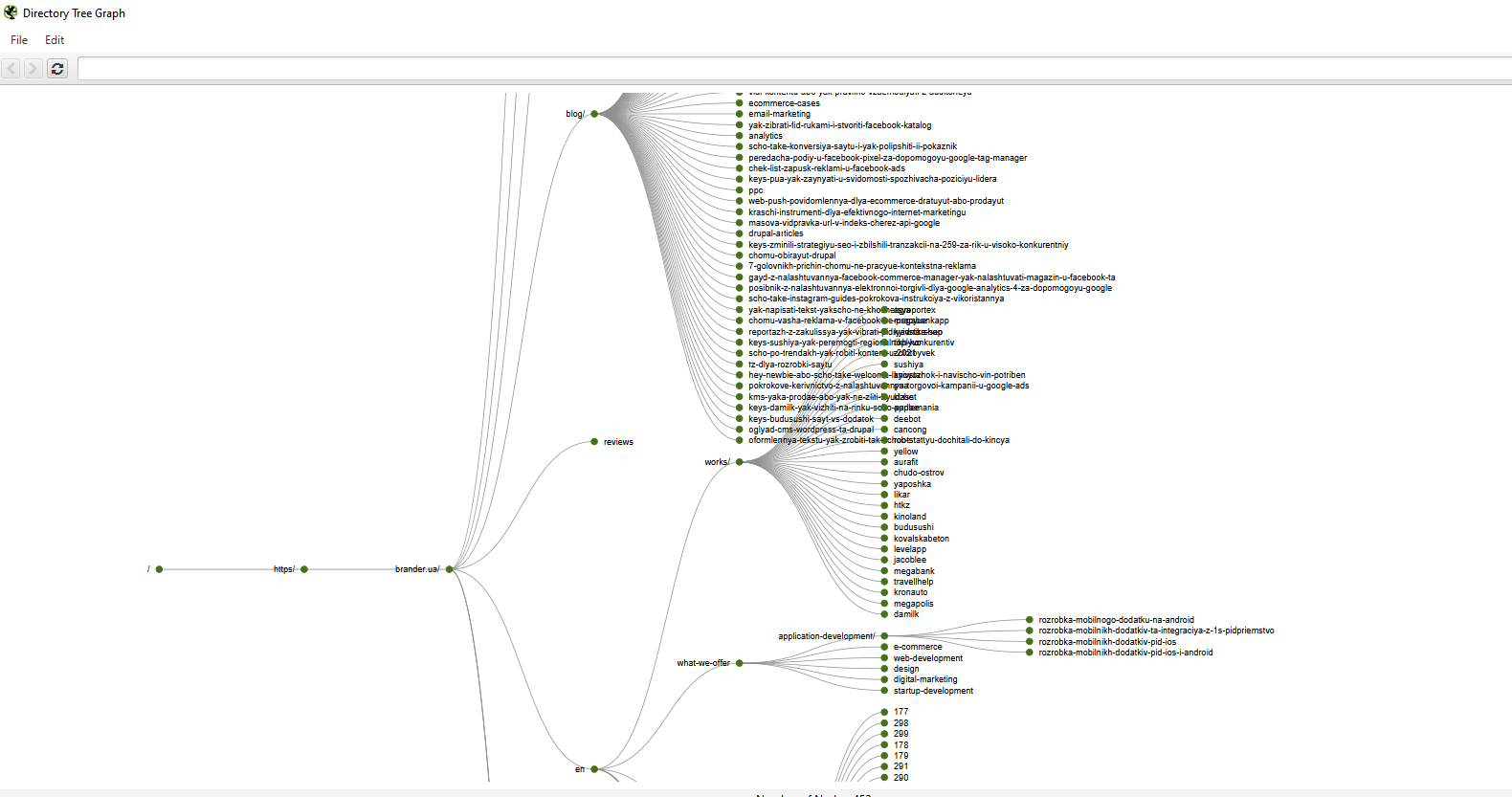

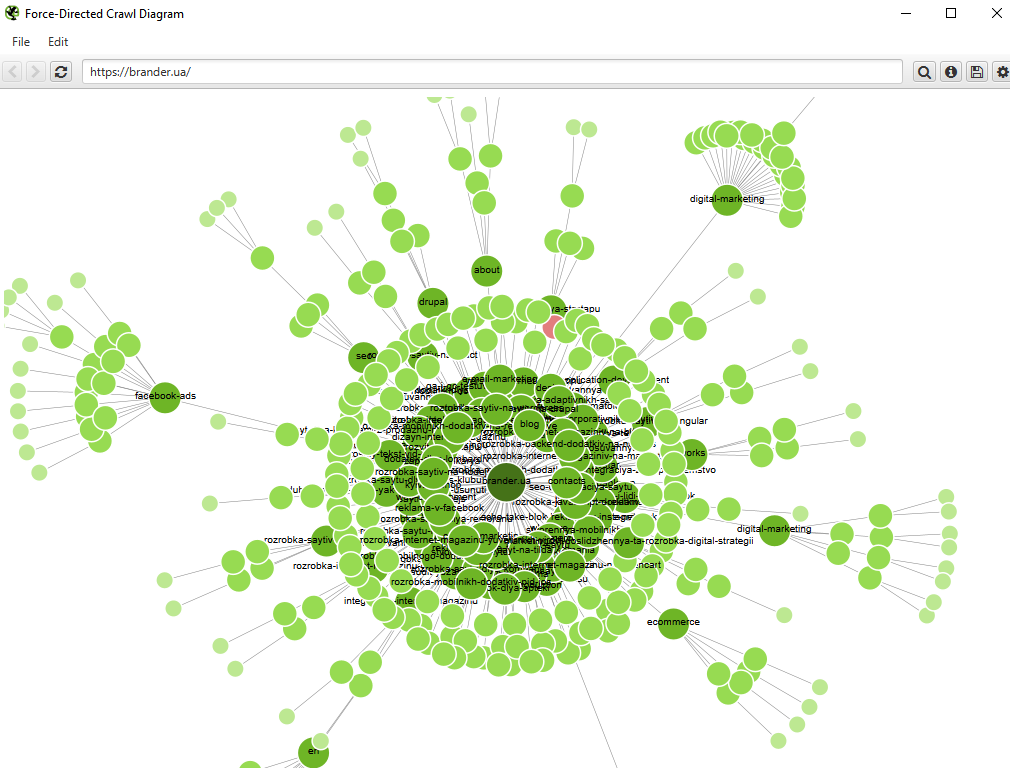

Функціонал Screaming Frog дозволяє отримати візуальну структуру каталогу сайту у вигляді графи або діаграми.

Описувати всі налаштування парсінгу програми SF можна довго, а й чи потрібно? У цій статті розповіла про всі найчастіші й найпотрібніші налаштування. У нішевих параметрах налаштування можна попорпатися після освоєння бази утиліти. Сподіваюся, було корисно. Успішних вам SEO-аналізів і топових позицій в SERP!