Дублі сторінок сайту: як їх виявити і усунути?

Одна з головних причин втрати трафіку і рейтингу — дубльований контент.

Дубльований контент — це дві або більше сторінок, що містять однаковий або дуже схожий контент. Пошукові системи прагнуть надати користувачам найкращі варіанти, відповідно, вони рідко будуть показувати повторювані фрагменти контенту. Замість цього вони будуть змушені вибрати, яка версія, на їхню думку, найкраще підходить для цього запиту. Саме тому дубльований контент знижує рейтинг сторінки в результатах пошуку.

Також дублі сторінок впливають на внутрішню контрольну вагу. Припустимо, на веб-сайті є дві ідентичні сторінки, кожна має 10 вхідних посилань. Цей сайт міг би використовувати вагу 20 посилань для підвищення рейтингу сторінки. Замість цього на сайті дві сторінки з 10 посиланнями. Ні те, ні інше не буде нормально ранжуватися і потрапляти в ТОП.

Дубльований контент також шкодить краулінговому бюджету і призводить до того, що потрібні вам сторінки не індексуються. І навпаки, можуть проіндексувати 2 ідентичні сторінки.

Чому виникають дублі на сайті?

- Помилки в системі управління контентом (CMS).

- Після переходу з http на https не налаштовується перенаправлення (301 редирект). Аналогічно, коли немає перенаправлення на головне дзеркало сайту (якщо веб-сайт доступний з www і без www, зі слешем і без нього в кінці).

- Додавання в URL-адресу get-параметрів і UTM-міток.

- Людський фактор. Веб-майстер може помилково продублювати сторінку.

- Зміни у структурі сайту, коли сторінки отримують нові адреси, а старі будуть збережені.

Різновиди дублів на сайті і чому вони з'являються

Повні дублі

Це сторінки сайту з однаковим контентом, доступні за різними URL:

- З www і без www:

https://test.ru і https://www.test.ru. - З http і https:

https://test.ru і http://test.ru. - Прописні і малі літери на різних рівнях вкладеності в URL:

https://test.ru/sample/ і https://test.ru/saAmpLe/ - Зі слешем на кінці URL і без слеша:

https://test.ru/sample/ і https://test.ru/sample. - З великою кількістю слешів у кінці або середині URL:

https://test.ru/////////, https://test.ru/////////sample/. - Дублі головної сторінки за адресами: /home, /index.php, /index.html, /index.htm, /main, /default:

https://test.ru/sample/ і https://test.ru/sample/index.html - З відсутніми рівнями укладення:

https://test.ru/category/sample/ і https://test.ru/sample/. - Із заміною дефіса на нижнє підкреслення або навпаки:

https://test.ru/test-url/ і https://test.ru/test_url. - При додаванні випадкових символів або цифр або як нового рівня вкладеності (в кінці або середині URL), або в існуючі рівні вкладеності:

https://test.ru/sample/gefYY7/ i https://test.ru/jerh1EE/sample/, https://test.ru/sample/ і https://test.ru/sample/56436/. - При додаванні * в кінці URL:

https://test.ru/sample/ і https://test.ru/sample/*. - З невірними рівнями вкладення:

https://test.ru/category/sample/ і https://test.ru/sample/category/.

Часткові дублі

Часткові дублі — це коли контент на сайті дублюється не в повному обсязі, а лише окремі елементи, при цьому URL, як правило, різний. Контент, який дублюється частково, не так просто знайти. А він також погано впливає на позиції у видачі.

Кілька видів часткових дублів:

- Опис товарів: зазвичай виникає, коли опис одного товару на сайті дублюється для іншого. Щоб описи не дублювалися, рекомендуємо їх унікалізувати для кожного товару.

- Повторювані метадані (title, description) і H1.

- Контент, що дублюється на фільтрах, сортуванні, в пошуку і на сторінках пагінації з повторюваним текстом, описами і метаданими.

- Контент, що дублюється, який повністю відповідає основній сторінці для друку або для скачування: https://test.ru/blog/blog1/ і https://test.ru/blog/blog1/printer.

Чому контент, який дублюється — це так погано?

Складно пояснити, чому дубльований контент — це погано, легше розповісти, чому унікальний контент — це добре.

Унікальний контент — один з кращих способів виділитися серед інших сайтів. Коли контент на вашому веб-сайті належить вам і тільки вам, ви виділяєтеся. У вас є те, чого немає ні в кого.

З іншого боку, коли ви використовуєте однаковий контент для опису ваших продуктів або послуг або повторно публікуєте його на інших сайтах, ви втрачаєте унікальність. А в разі дублювання контенту на сайті окремі сторінки втрачають свою унікальність.

Це тягне за собою:

- Проблеми з індексацією: робот буде індексувати кілька сторінок, які дублюються, що потягне за собою неправильну індексацію, витрату краулінгового бюджету. І внаслідок цього потрібні вам сторінки можуть не потрапити у видачу.

- Некоректні сторінки у видачі: в цьому випадку може бути два варіанти. Або у видачу потрапить не та сторінка, яка вам потрібна, або через конкуренцію між собою ж не потрапить жодна.

- Посилальну масу: незалежно від того, на сайті або поза ним, весь контент, що дублюється, конкурує сам з собою. Кожна версія може привернути увагу і посилання, але жодна з них не отримає повної цінності, яку отримала б, якби була єдиною і унікальною версією. А в іншому випадку ще й втратить частину своєї посилальної маси, розпорошуючись на дві сторінки одночасно.

Знаходимо дублі

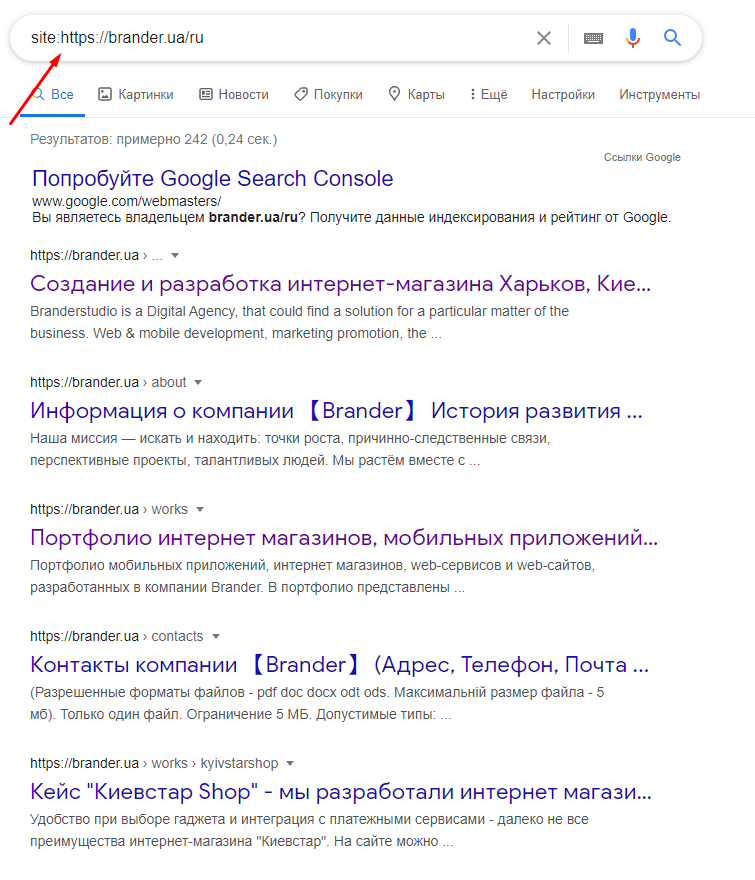

Оператор site

Почнемо з оператора site:. Цей запит дасть вам розуміння, скільки сторінок знаходиться в індексі Google. А також можна побачити сторінки, які повторюються повністю, які і будуть означати, що це дублі.

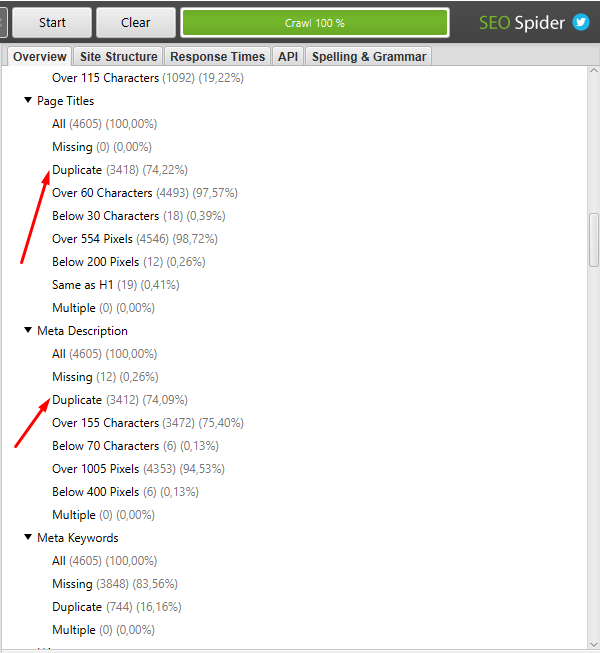

Парсери і сервіси Netpeak Spider, Xenu, Screaming frog

Ви можете завантажити, наприклад, screaming frog і використовувати його для сканування всього сайту. Цей інструмент дозволяє вам зібрати дублі на сайті, такі як повторювані метадані сторінок. Для запуску нового сканування скопіюйте і вставте своє доменне ім'я в сканер і натисніть «Пуск», після клацніть на Duplicate.

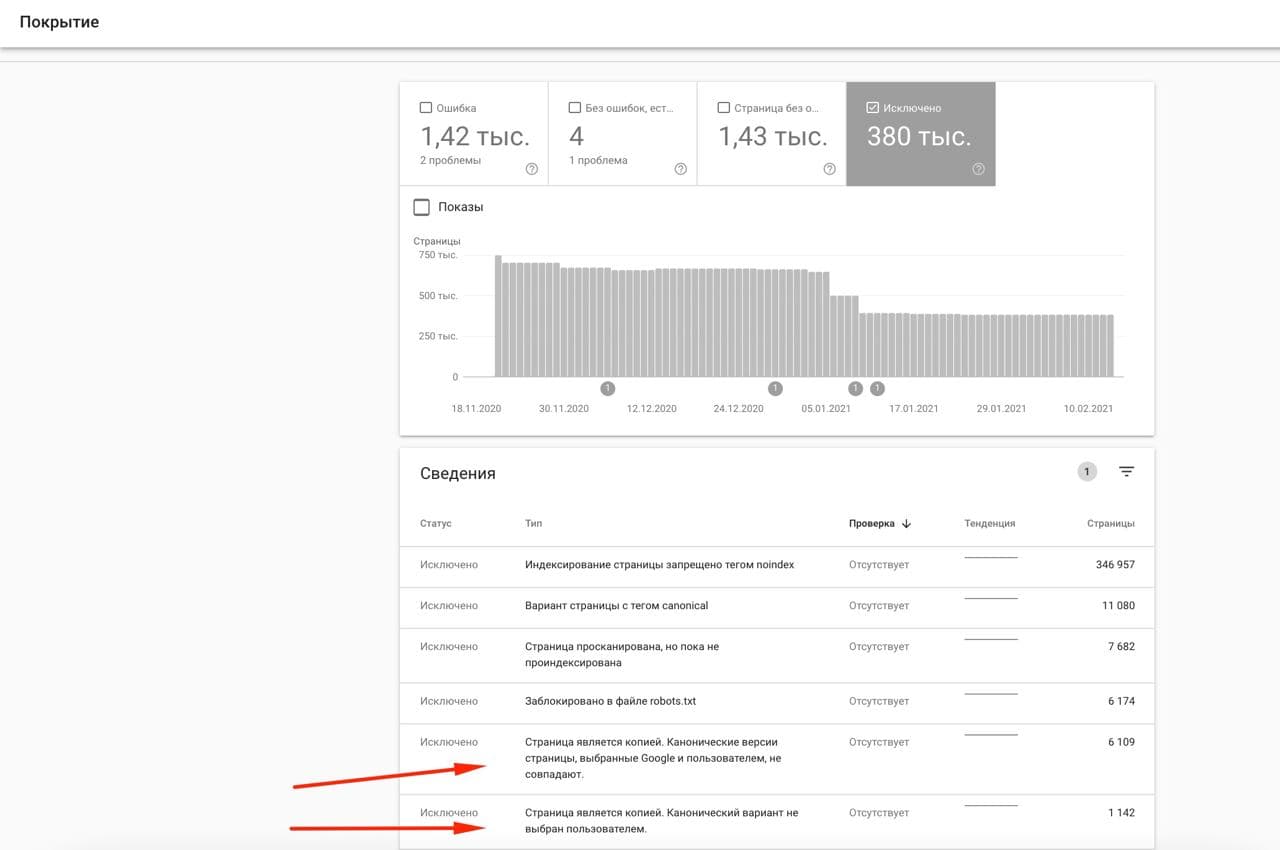

Search Console

Іноді дубльований контент можливо виявити в Інструментах Google — у Search Console. Ви можете подивитися їх у розділі "Покриття" у підрозділі "Виключено".

Вручну на сайті

Найчастіше дублі виникають на таких сторінках, як:

- пагінація;

- сортування;

- фільтри.

Щоб уникнути цього, необхідно навчитися правильно видаляти дублі сторінок. Як це зробити, дивіться нижче у статті.

Видаляємо дублі правильно

Дубльований контент — це проблема, яка може вплинути на ваш звичайний трафік, контрольну вагу, позиції у видачі. Плюси в тому, що це легко можна виправити. Три найшвидших способи розв'язання проблем з дублюванням контенту:

301 редирект

Ідеальний варіант. 301 редирект перенаправляє користувача на потрібну сторінку, об'єднує вагу посилань. Важливо: використовуйте 301 редирект тільки тоді, коли була виявлена і усунена причина появи дублів.

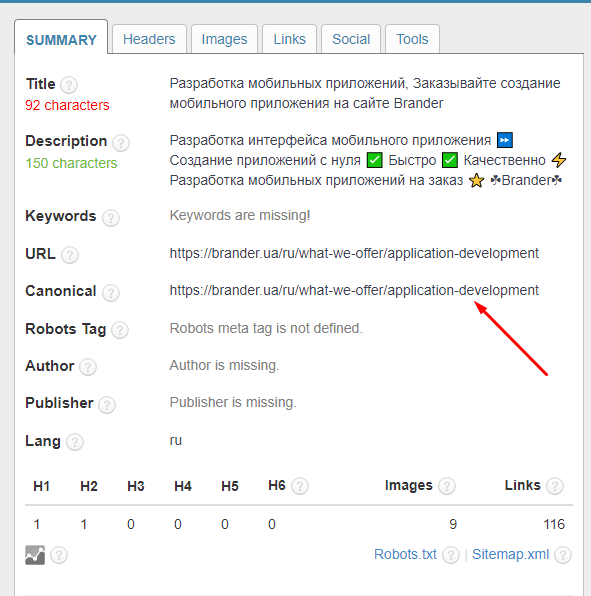

Canonical

У пошуковій оптимізації канонічні теги визначають, яку сторінку слід проіндексувати, і призначають посилання на них. Теги — це пропозиція для пошукової системи, а не команди на зразок 301 редиректу. Канонічний тег підходить, коли ви хочете, щоб користувачам було доступно кілька версій сторінки, наприклад, сторінки сортування, фільтри, пагінація.

Варіант з канонічними тегами підходить, коли 301 редирект непрактичний або дубльована сторінка повинна залишатися доступною. Наприклад, якщо у вас є дві сторінки товарів, одна відсортована за спаданням, а інша — за зростанням. В такому випадку підійде саме Canonical, щоб не перенаправляти з однієї сторінки на іншу.

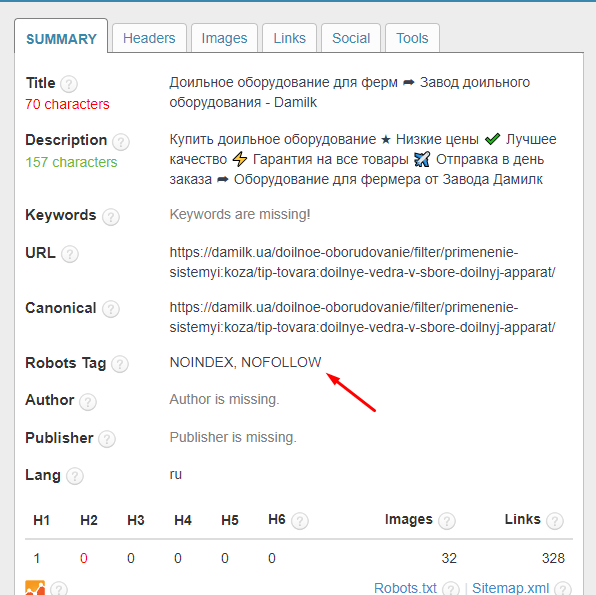

Канонікал можна перевірити в інструменті SEO META in 1 click, а також у коді сайту, який буде мати такий вигляд:

<link rel="canonical" href="https://..." />Метатеги

Ви можете використовувати метатеги, щоб заборонити пошуковим системам індексувати певну сторінку.

Цей тег повідомляє Google не індексувати посилання на певній сторінці, але дозволяє сканувати їх. Іншими словами, ви говорите Google не брати до уваги ці посилання для ранжування.

<html>

<head>

<title> ... </title>

<meta name = "robots" content = "noindex, nofollow">

</head>Метатеги працюють найкраще, коли ви хочете, щоб ця сторінка була доступна користувачеві, але не індексувалась ботом.

Файл robots.txt

Завдяки файлу robots.txt ми даємо роботу рекомендацію, які сторінки сайту не потрібно сканувати. На відміну від метатега, robots.txt має рекомендаційний характер, а не вказівний. Тому в будь-якому випадку є ризик, що сторінка проіндексується.

У robots.txt потрібно прописати директиву "Disallow" — саме вона забороняє роботам відвідувати сторінки, які нам не потрібні.

User-agent: *

Disallow: / contactВисновок

Виявлення дублів — це дуже важливий етап внутрішньої оптимізації сайту.

Невелика кількість повторюваного або шаблонного контенту не принесе шкоди вашому сайту. Але потрібно уважно стежити за технічними помилками SEO, які призводять до створення сотень або тисяч сторінок дублів, що може завдати серйозної шкоди вашому краулінговому бюджету.

Якщо вам потрібен надійний метод видалення дублів, кращі варіанти — 301 редирект, налаштування Canonical, файлу robots.txt і метатегів Noindex, Nofollow.

Як бачите, немає нічого складного в пошуку і усуненні дублів. Використовуйте ці рекомендації, і тоді ваш сайт безумовно вийде в ТОП.