Как выявить и устранить дубли страниц сайта?

Одна из главных причин потери трафика и рейтинга — дублированный контент.

Дублированный контент — это две или более страниц, содержащих одинаковый или очень похожий контент. Поисковые системы стремятся предоставить пользователям наилучшие варианты, соответственно, они редко будут показывать повторяющиеся фрагменты контента. Вместо этого они будут вынуждены выбрать, какая версия, по их мнению, лучше всего подходит для этого запроса. Именно поэтому дублированный контент снижает рейтинг страницы в результатах поиска.

Также дубли страниц влияют на внутренний ссылочный вес. Допустим, на веб-сайте есть две идентичные страницы, каждая имеет 10 входящих ссылок. Этот сайт мог бы использовать вес 20 ссылок для повышения рейтинга страницы. Вместо этого на сайте две страницы с 10 ссылками. Ни то, ни другое не будет нормально ранжироваться и оказываться в ТОПе.

Дублированный контент также вредит краулинговому бюджету и приводит к тому, что нужные вам страницы по итогу не индексируются. И напротив, могут проиндексироваться 2 идентичные страницы.

Почему возникают дубли на сайте?

- Ошибки в системе управления контентом (CMS).

- После перехода с http на https не настраивается перенаправление (301 редирект). Аналогично, когда нет перенаправления на главное зеркало сайта (если веб-сайт доступен с www и без www, со слешем и без него в конце).

- Добавление в URL-адрес get-параметров и UTM-меток.

- Человеческий фактор. Веб-мастер может по ошибке продублировать страницу.

- Изменения в структуре сайта, когда страницы получают новые адреса, а старые не удаляются.

Разновидности дублей на сайте и почему они появляются

Полные дубли

Это страницы сайта с одинаковым контентом, доступные по разным URL:

- С www и без www:

https://test.ru и https://www.test.ru. - С http и https:

https://test.ru и http://test.ru. - Прописные и строчные буквы на разных уровнях вложенности в URL:

https://test.ru/sample/ и https://test.ru/saAmpLe/. - Со слешем на конце URL и без слеша:

https://test.ru/sample/ и https://test.ru/sample. - С большим количеством слешей в конце или середине URL:

https://test.ru/////////, https://test.ru/////////sample/. - Дубли главной страницы по адресам: /home, /index.php, /index.html, /index.htm, /main, /default:

https://test.ru/sample/ и https://test.ru/sample/index.html. - С отсутствующими уровнями вложенности:

https://test.ru/category/sample/ и https://test.ru/sample/. - С заменой дефиса на нижнее подчеркивание или наоборот:

https://test.ru/test-url/ и https://test.ru/test_url. - При добавлении случайных символов или цифр либо в качестве нового уровня вложенности (в конце или середине URL), либо в существующие уровни вложенности:

https://test.ru/sample/gefYY7/ и https://test.ru/jerh1EE/sample/, https://test.ru/sample/ и https://test.ru/sample/56436/. - При добавлении * в конце URL:

https://test.ru/sample/ и https://test.ru/sample/*. - С неверными уровнями вложенности:

https://test.ru/category/sample/ и https://test.ru/sample/category/.

Частичные дубли

Частичные дубли — это когда контент на сайте дублируется не полностью, а только его отдельные элементы, при этом URL, как правило, разный. Частичный дублирующий контент не так просто найти. При этом он также плохо влияет на позиции в выдаче.

Несколько видов частичных дублей:

- Описание товаров. Обычно возникает, когда описание одного товара на сайте дублируется для другого. Чтобы описания не повторялись, рекомендуем их уникализировать для каждого товара.

- Повторяющиеся метаданные (title, description) и H1.

- Дублирующийся контент на фильтрах, сортировке, в поиске и на страницах пагинации с повторяющимся текстом, описаниями и метаданными.

- Дублирующийся контент, который полностью соответствует основной странице для печати или для скачивания: https://test.ru/blog/blog1/ и https://test.ru/blog/blog1/printer.

Почему дублирующийся контент — это так плохо?

Сложно объяснить, почему дублированный контент — это плохо, легче рассказать, почему уникальный контент — это хорошо.

Уникальный контент — один из лучших способов выделиться среди других сайтов. Когда контент на вашем веб-сайте принадлежит вам и только вам, вы выделяетесь. У вас есть то, чего нет ни у кого.

С другой стороны, когда вы используете одинаковый контент для описания ваших продуктов или услуг или повторно публикуете его на других сайтах, вы теряете уникальность. А в случае дублирования контента на сайте отдельные страницы теряют свою уникальность.

Это влечет за собой:

- Проблемы с индексацией: робот будет индексировать несколько дублирующихся страниц, что повлечет собой неправильную индексацию, расход краулингового бюджета. И по итогу нужные вам страницы могут не попасть в выдачу.

- Некорректные страницы в выдаче: в этом случае может быть два варианта. Или в выдачу попадет не та страница, которая вам нужна, или из-за конкуренции между собой же не попадет ни одна.

- Ссылочный вес: независимо от того, на сайте или вне его, весь дублирующийся контент конкурирует сам с собой. Каждая версия может привлечь внимание и ссылки, но ни одна из них не получит полной ценности, которую получила бы, если бы была единственной и уникальной версией. А в противном случае еще и потеряет часть своего ссылочного веса, распыляясь на две страницы одновременно.

Находим дубли

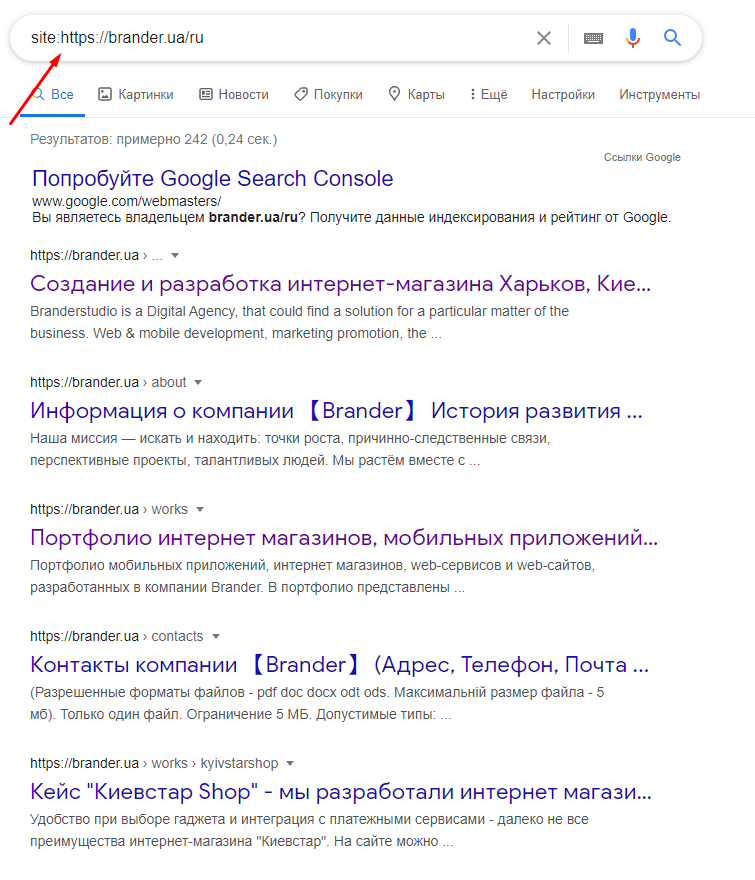

Оператор site

Начнем с оператора site:. Этот запрос даст вам понимание, сколько страниц находится в индексе Google. А также можно увидеть полностью повторяющиеся страницы, которые и будут означать, что это дубли.

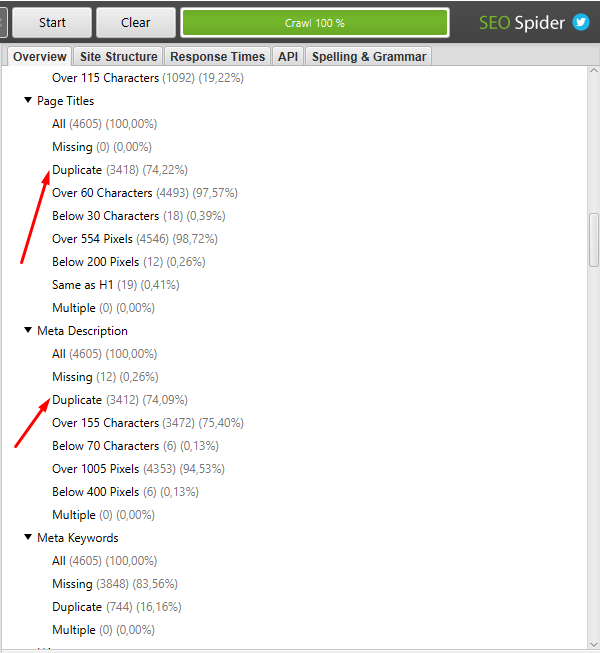

Парсеры и сервисы Netpeak Spider, Xenu, Screaming frog

Вы можете скачать, например, screaming frog и использовать его для сканирования всего сайта. Этот инструмент позволяет собрать дубли на сайте, такие как повторяющиеся метаданные страниц. Для запуска нового сканирования скопируйте и вставьте свое доменное имя в сканер и нажмите «Пуск», после щелкните на Duplicate.

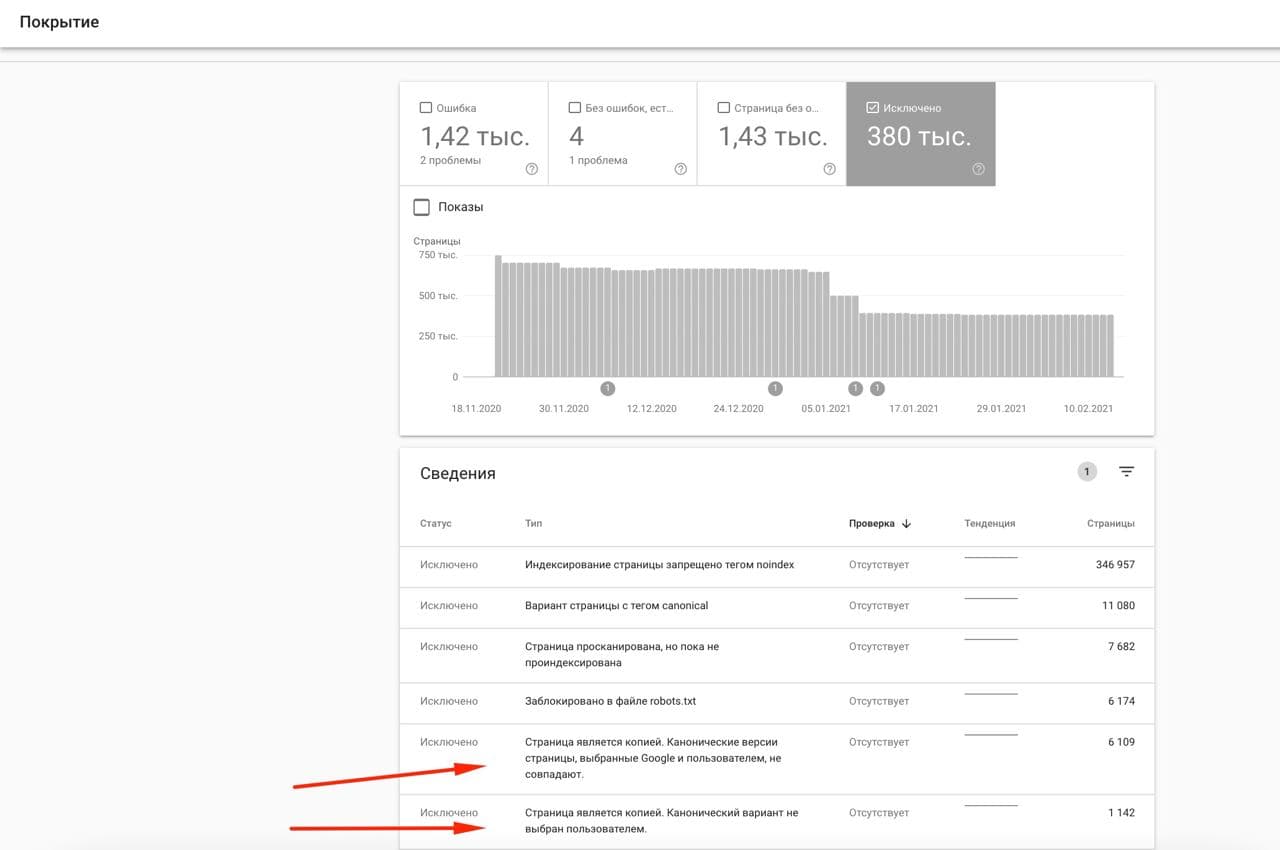

Search Console

Иногда дублированный контент можно обнаружить в Инструментах Google — Search Console. Вы можете посмотреть их в разделе “Покрытие” в подразделе “Исключено”.

Вручную на сайте

Чаще всего дубли возникают на таких страницах, как:

- пагинация;

- сортировка;

- фильтры.

Чтобы избежать этого, необходимо научиться правильно удалять дубли страниц. Как это сделать, смотрите ниже в статье.

Удаляем дубли правильно

Дублированный контент — это проблема, которая может повлиять на ваш обычный трафик, ссылочный вес, позиции в выдаче. Плюсы в том, что это легко можно исправить. Три самых быстрых способа решения проблем с дублированием контента:

301 редирект

Идеальный вариант. 301 редирект перенаправляет пользователя на нужную страницу, объединяет вес ссылок. Важно: используйте 301 редирект только когда была выявлена и устранена причина появления дублей.

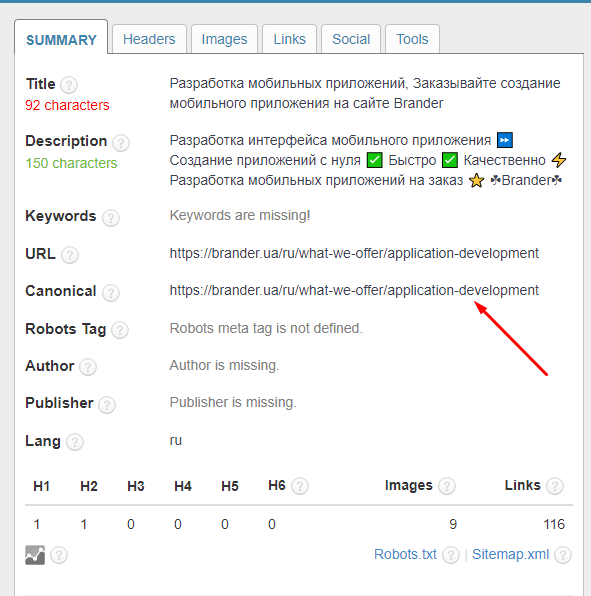

Canonical

В поисковой оптимизации канонические теги определяют, какую страницу следует проиндексировать, и назначают ссылки на них. Теги — это предложение для поисковой системы, а не команды вроде 301 редиректа. Канонический тег подходит, когда вы хотите, чтобы пользователям было доступно несколько версий страницы, например, страницы сортировки, фильтры, пагинация.

Вариант с каноническими тегами подходит, когда 301 редирект непрактичен или дублирующая страница должна оставаться доступной. Например, если у вас есть две страницы товаров, одна отсортирована по убыванию, а другая — по возрастанию. В таком случае подойдет именно Canonical, чтобы не перенаправлять с одной страницы на другую.

Каноникал можно проверить в инструменте SEO META in 1 click, а также в коде сайта, который будет иметь такой вид:

<link rel="canonical" href="https://..." />Метатеги

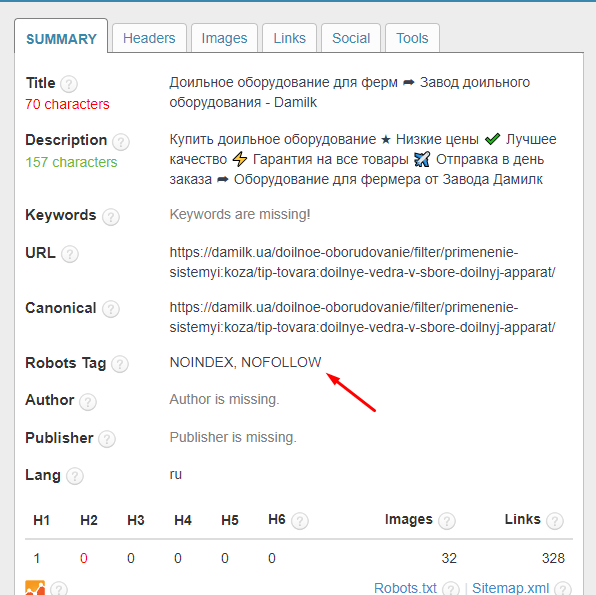

Вы можете использовать метатеги, чтобы запретить поисковым системам индексировать определенную страницу.

Этот тег сообщает Google не индексировать ссылки на определенной странице, но позволяет сканировать их. Другими словами, вы говорите Google не принимать во внимание эти ссылки для ранжирования.

<html>

<head>

<title> ... </title>

<meta name = "robots" content = "noindex, nofollow">

</head>Метатеги работают лучше всего, когда вы хотите, чтобы эта страница была доступна пользователю, но не индексировалась ботом.

Файл robots.txt

Благодаря файлу robots.txt мы даем роботу рекомендацию, какие страницы сайта не нужно сканить. В отличии от метатега, robots.txt имеет рекомендательный характер, а не указательный. Поэтому в любом случае есть риск, что страница проиндексируется.

В robots.txt нужно прописать директиву “Disallow” — именно она запрещает роботам посещать страницы, которые нам не нужны.

User-agent: *

Disallow: / contactВывод

Выявление дублей — это очень важный этап внутренней оптимизации сайта.

Небольшое количество повторяющегося или шаблонного контента не принесет вреда вашему сайту. Но нужно внимательно следить за техническими ошибками SEO, которые приводят к созданию сотен или тысяч страниц дублей, что может нанести серьезный ущерб вашему краулинговому бюджету.

Если вам нужен надежный метод удаления дублей, лучшие варианты — 301 редирект, настройка Canonical, файл robots.txt и метатегов Noindex, Nofollow.

Как видите, нет ничего сложного в поиске и устранение дублей. Используйте эти рекомендации, и тогда ваш сайт определенно выйдет в ТОП.